Разделы

Центр коллективного пользования

Центр коллективного пользования ИММ УрО РАН «Суперкомпьютерный центр ИММ УрО РАН» (СКЦ ИММ УрО РАН)

СКЦ ИММ УрО РАН действуют на базе двух структурных научных подразделений ИММ УрО РАН (отдел вычислительной техники и отдел системного обеспечения). Деятельность СКЦ ИММ УрО РАН регламентируется Положением о центре, планами работы, приказами директора ИММ УрО РАН. СКЦ ИММ УрО РАН работает в режиме вычислительного центра коллективного пользования. Главное направление деятельности СКЦ ИММ УрО РАН - решение фундаментальных и прикладных ключевых задач, обусловливающих научно-технический прогресс в экономике и бизнесе и ведущих к получению новых знаний и информации.

Базовая организация: Федеральное государственное бюджетное учреждение науки Институт математики и механики им. Н. Н. Красовского Уральского отделения Российской академии наук (сайт); адрес: 620108, Российская Федерация, г. Екатеринбург, ул. Софьи Ковалевской, д. 16.

Руководитель: заведующий отделом системного обеспечения Игумнов Александр Станиславович, телефон: +7 (343) 375-35-11; e-mail: parallel@imm.uran.ru.

Уникальная установка суперкомпьютер "Уран" расположена по адресу: Екатеринбург, ул. Софьи Ковалевской, д. 16.

Перечень оборудования СКЦ ИММ УрО РАН

Образец заявки на регистрацию пользователей

Интерактивная форма подачи заявок

Методики измерений, применяемые в ЦКП - не применимо к услугам СКЦ ИММ УрО РАН.

Как ссылаться на центр коллективного пользования

В публикациях по проектам, выполненным с использованием СКЦ ИММ УрО РАН, необходимо давать ссылки на соответствующие вычислительные ресурсы, например, включив в них фразу:

«При проведении работ был использован суперкомпьютер «Уран» ИММ УрО РАН».

Для англоязычных публикаций можно использовать формулировку подобную этой:

«Computations were performed on the Uran supercomputer at the IMM UB RAS».

Положение о Суперкомпьютерном центре ИММ УрО РАН

В документах, расположенных на данной странице, находятся сканы приказов о создании вычислительного Центра коллективного пользования научным оборудованием ИММ УрО РАН и утвержденное положение о суперкомпьютерном центре ИММ УрО РАН.

| Прикрепленный файл | Размер |

|---|---|

| 3.03 МБ | |

| 2.09 МБ | |

| 285.85 КБ | |

| 2.21 МБ |

План работы СКЦ ИММ УрО РАН

Текущая загрузка суперкомпьютера "Уран"

План работы на 2025 год

| Организация | Примечания | Способ распределения ресурсов |

|---|---|---|

| ИММ УрО РАН | Разделяемый и выделенный | |

| ИГФ УрО РАН | По договору | Разделяемый |

| ИЭФ УрО РАН | По договору | Разделяемый |

| ИФМ УрО РАН | По договору | Разделяемый |

| ИМ УрО РАН | По договору | Разделяемый |

| ИХТТ УрО РАН | По договору | Разделяемый |

| ИМЕТ УрО РАН | По договору | Разделяемый |

| ИВТЭ УрО РАН | По договору | Разделяемый |

| ГИ УрО РАН | По договору | Разделяемый |

| ИМСС УрО РАН | По договору | Разделяемый |

| ИМАШ УрО РАН | По договору | Разделяемый |

| ИТФ УрО РАН | По договору | Разделяемый |

| Студенты | Аспиранты ИММ УрО РАН и магистры совместной с ИММ УрО РАН кафедры УрФУ |

Разделяемый |

| УрФУ | Сотрудники УрФУ совместной с ИММ УрО РАН кафедры | Разделяемый |

| Коммерческие договоры | Не более 10% в пересчете на процессорное время | Разделяемый и выделенный |

| Тех. обслуживание | Не более 25% в пересчете на процессорное время | Выделенный |

Примечание:

“Разделяемый способ распределения ресурсов” – совместное

использование ресурса несколькими пользователями и динамическое планирование

ресурсов по алгоритмам системы запуска задач;

“Выделенный способ распределения ресурсов” – выделение части

ресурсов кластера в единоличное пользование пользователю или группе

пользователей.

Правила конкурсного отбора заявок

В соответствии с регламентом доступа к ресурсам центра коллективного пользования научным оборудованием ИММ УрО РАН «Суперкомпьютерный центр ИММ УрО РАН» план работы ЦКП формируется на основе поступающих заявок. По ним на каждый год составляется расписание работы ЦКП. Заявки могут быть поданы как в бумажном, так и в электронном виде. За рассмотрение заявок отвечает руководитель ЦКП. Полученные заявки должны быть рассмотрены в срок не более двух недель с момента поступления заявки.

При рассмотрении заявок принимаются во внимание: содержательная часть работы, научная значимость и актуальность задачи, степень соответствия заявки возможностям оборудования ЦКП, запрашиваемое время работы оборудования, поддержка молодых ученых. По результатам рассмотрения заявок руководитель ЦКП принимает решение о возможности заключения с пользователем договора на проведение научных работ и оказание услуги и включает заявку в план работ. Решение о невозможности заключения договора должно быть мотивированным и доведено до сведения пользователя не позднее десяти дней со дня принятия такого решения. Научные подразделения ИММ УрО РАН получают допуск к работе с использованием вычислительных ресурсов без заключения договоров на основании заявки.

Перечень причин для отклонения заявки.

- Отсутствие технической возможности исполнить заказ центром коллективного пользования.

- Неисполнение, ненадлежащее исполнение условий договора заказчиком.

Решение и мотивация о невозможности выполнения заявки доводятся до сведения пользователя не позднее десяти дней со дня его принятия.

Регламент доступа

Регламент доступа к ресурсам центра коллективного пользования научным оборудованием ИММ УрО РАН «Суперкомпьютерный центр ИММ УрО РАН»

Порядок выполнения работ и оказания услуг при проведении научных исследований; порядок осуществления экспериментальных разработок в интересах третьих лиц.

Центр коллективного пользования «Суперкомпьютерный центр ИММ УрО РАН» (далее - ЦКП) не имеет статуса юридического лица. ЦКП представляет собой научно-организационную структуру, обладающую современным научным оборудованием, высококвалифицированными кадрами и обеспечивающую на имеющемся оборудовании проведение научных исследований и оказание услуг, в том числе в интересах внешних пользователей (физических лиц и сторонних организаций).

Вычислительную, телекоммуникационную и информационную базу ЦКП составляют высокопроизводительные вычислительные системы, структурированная локальная информационно-вычислительная сеть, информационные и вспомогательные серверы.

Перечень типовых услуг, оказываемых заявителям с использованием оборудования ЦКП, представлен на официальном сайте ЦКП.

Использование оборудования ЦКП при проведении заявителями, указанными в пункте 4.4 Положения о центре коллективного пользования научным оборудованием ИММ УрО РАН, фундаментальных и прикладных научных исследований в рамках утвержденного государственного задания организуется и осуществляется на конкурсной основе безвозмездно на основании договоров безвозмездного оказания услуг доступа к ресурсам центра коллективного пользования научным оборудованием ИММ УрО РАН «Суперкомпьютерный центр ИММ УрО РАН».

Использование оборудования ЦКП в интересах внешних заявителей при проведении прикладных исследований реализуется на возмездной основе в соответствии с договором оказания услуг предоставления ресурсов Центра коллективного пользования научным оборудованием ИММ УрО РАН «Суперкомпьютерный центр ИММ УрО РАН». Стоимость оказания услуг ЦКП в этом случае определяется фактическими затратами, необходимыми для выполнения работ.

Права на результаты интеллектуальной деятельности, получаемые в ходе проведения научных исследований и оказания услуг принадлежат заявителям, в отдельных случаях права на результаты интеллектуальной деятельности, регулируются договором между базовой организацией и заявителем.

Условия допуска к работе с использованием вычислительных ресурсов ЦКП

План работы ЦКП формируется на основе поступающих заявок. По ним на каждый год составляется расписание работы ЦКП.

Заявки могут быть поданы как в бумажном, так и в электронном виде. За рассмотрение заявок отвечает руководитель ЦКП. Полученные заявки должны быть рассмотрены в срок не более двух недель с момента поступления заявки.

При рассмотрении заявок принимаются во внимание: содержательная часть работы, научная значимость и актуальность задачи, степень соответствия заявки возможностям оборудования ЦКП, запрашиваемое время работы оборудования, поддержка молодых ученых.

По результатам рассмотрения заявок руководитель ЦКП принимает решение о возможности заключения с пользователем договора на проведение научных работ и оказание услуги и включает заявку в план работ. Решение о невозможности заключения договора должно быть мотивированным и доведено до сведения пользователя не позднее десяти дней со дня принятия такого решения. Научные подразделения ИММ УрО РАН получают допуск к работе с использованием вычислительных ресурсов без заключения договоров на основании заявки.

Перечень причин для отклонения заявки.

- Отсутствие технической возможности исполнить заказ центром коллективного пользования.

- Неисполнение, ненадлежащее исполнение условий договора заказчиком.

Решение и мотивация о невозможности выполнения заявки доводятся до сведения пользователя не позднее десяти дней со дня его принятия.

Стоимость вычислительных услуг

Вычислительные услуги предоставляются на основе договора, заключаемого в соответствии с Положением о центре коллективного пользования ИММ УрО РАН от 18.01.2016.

Стоимость вычислительных услуг (без учета НДС) в 2025 году:

- Одной GPU-карты типа Tesla M2090 - 15 руб*час

- Одной GPU-карты типа Tesla K40 - 40 руб*час

- Одной GPU-карты типа Tesla V100 - 120 руб*час.

- Одной GPU-карты типа Tesla A100 - 180 руб*час.

- Ядро CPU - 2 руб*час.

При выделении вычислительных узлов в монопольное использование, плата взимается за все вычислительные ресурсы, физически размещенные на этих узлах, вне зависимости от их фактической загрузки.

Правила использования кластера

- Пользователь получает логин (учетную запись) и пароль доступа по заявке от организации на основании заключенного договора доступа к ресурсам СКЦ ИММ УрО РАН.

- Полученный логин должен использоваться только лицом, указанным в заявке, и только для решения задач, указанных в заявке. При выявлении нецелевого использование вычислительных ресурсов администратор кластера блокирует доступ к учетной записи до устранения нарушений.

- В случае изменения регистрационных данных (изменение контактной информации и т.п.) пользователь обязан сообщить об этом администратору кластера в течение 5 рабочих дней по адресу otchet-par@list.uran.ru, а также оформить в течение месяца новую заявку на регистрацию пользователя.

- Объём хранилища данных в СКЦ ИММ УрО РАН для каждого пользователя ограничивается 100 GB (см. Ограничения по ресурсам). Если для работы необходимы большие ресурсы, пользователь должен согласовать их выделение с администратором кластера.

- В публикациях по проектам, выполненным с использованием СКЦ ИММ УрО РАН, необходимо давать ссылки на соответствующие вычислительные ресурсы, например, включив в них фразу: «При проведении работ был использован суперкомпьютер «Уран» ИММ УрО РАН». Для англоязычных публикаций можно использовать формулировку подобную этой: «Computations were performed on the Uran supercomputer at the IMM UB RAS».

- Ежегодно в ноябре месяце организация, заключившая договор на длительный срок, должна предоставить заявку для перерегистрации учетных записей на следующий календарный год и краткий отчет о проведенных исследованиях, выполненных с использованием СКЦ ИММ УрО РАН в текущем году. Требования к отчёту представлены на сайте.

- При необходимости проведения расчетов в коммерческих целях (например, вне программ и проектов по государственному заданию) организация должна подать заявку на заключение договора возмездного оказания услуг доступа к ресурсам СКЦ ИММ УрО РАН.

Заявка на регистрацию пользователей

ЗАЯВКА ОФОРМЛЯЕТСЯ НА БЛАНКЕ ОРГАНИЗАЦИИ

Директору ИММ УрО РАН

Н. Ю. Лукоянову

Заявка на регистрацию потребителя ИТ-Услуг на 20.. год

к договору безвозмездного оказания услуг доступа к ресурсам центра коллективного пользования научным

оборудованием ИММ УрО РАН «Суперкомпьютерный центр ИММ УрО РАН»

№_____ от «__»_________201__ г.

________Название организации_______ просит предоставить доступ к вычислительным ресурсам Федерального государственного бюджетного учреждения науки Института математики и механики им. Н.Н. Красовского Уральского отделения Российской академии наук следующим сотрудникам нашей организации (института):

1. Источник финансирования ________________

___список пользователей, контактный телефон, e-mail каждого пользователя___

С использованием ресурсов СКЦ ИММ УрО РАН планируется решение задач, предусмотренных государственным заданием_____общее описание круга решаемых задач с ожидаемыми результатами от использования вычислительных ресурсов.

2. Источник финансирования ________________

___список пользователей, контактный телефон, e-mail каждого пользователя___

С использованием ресурсов СКЦ ИММ УрО РАН планируется решение задач, предусмотренных государственным заданием_____общее описание круга решаемых задач с ожидаемыми результатами от использования вычислительных ресурсов.

3. и т.д.

При отсутствии у пользователей опыта работы с вычислительной техникой такого уровня требуется проинформировать о необходимости заключения отдельного договора по организации курса обучения___.

Директор _____подпись_________ /_расшифровка подписи_/

__________________________________________________

ВНИМАНИЕ!!!

1. Заявка оформляется на бланке организации.

2. Список пользователей необходимо сгруппировать по источникам финансирования.

3. Пользователь может быть включен в несколько групп.

4. Источник финансирования: регистрационный номер НИОКТР в https://www.rosrid.ru/ и наименование НИОКТР, по которому финансируется работа.

В случае изменения сведений, указанных в заявке, в течение срока действия договора должна быть подана новая заявка, оформленная надлежащим образом.

Данное письмо отправить:

-

По адресу 620108, г. Екатеринбург, ул. Софьи Ковалевской, 16. Копия может быть отправлена по факсу: (343)374-25-81 - это основная заявка.

-

Электронный вариант письма в формате Word (текст) по адресу parallel@imm.uran.ru - информация для администратора.

Проект договора на предоставление услуг ЦКП

На этой странице вы можете скачать PDF файл с проектом договора на предоставление вычислительных услуг суперкомпьютерного центра коллективного пользования УрО РАН.

| Прикрепленный файл | Размер |

|---|---|

| 2.7 МБ |

Требования к отчету об использовании вычислительных ресурсов

Отчетные материалы предоставляются один раз в год не позднее 20 ноября отчетного года от групп пользователей, работающих над одной темой, объединяются в один файл отчета от организации.

Содержание отчета по отдельному проекту (НИР), выполненному с участием центра коллективного пользования:

- ТИТУЛЬНЫЙ ЛИСТ оформляется на первой странице отчета, информация по НИР – со второго листа отчета.

- Наименование НИР совпадает с НИОКТР, зарегистрированной в домене гиснаука.рф (https://xn--80aahulq1as.xn--p1ai/). Наименование НИР может отличаться от наименования НИОКТР, если выполненная работа является частью НИОКТР.

- Руководитель НИОКТР с указанием ФИО, должности, ученой степени.

- Список участников проекта с указанием ФИО, должности, ученой степени каждого участника.

- Заказчик - информация из домена гиснаука.рф (https://xn--80aahulq1as.xn--p1ai/).

- Источник финансирования: регистрационный номер НИОКТР, зарегистрированный в домене гиснаука.рф (https://xn--80aahulq1as.xn--p1ai/) и наименование НИОКТР, по которому финансируется работа.

- Приоритетное направление развития науки, технологий и техники в РФ в соответствии с Указом Президента Российской Федерации в редакции от 16.12.2015 г. № 623 ( http://www.kremlin.ru/acts/bank/33514 ).

- Направление фундаментальных исследований в соответствии с Программой фундаментальных научных исследований на 2021-2030 годы (https://docs.cntd.ru/document/573319222?marker=64U0IK ).

- Направление исследования в соответствии с классификатором РНФ (https://rscf.ru/contests/classification).

- Критическая технология РФ утверждена Президентом Российской Федерации 7 июля 2011 г., Пр-N 899 ( http://www.kremlin.ru/acts/bank/33514).

- Приоритетные направления научно-технологического развития в РФ в соответствии с Указом Президента РФ от 18 июня 2024 г. № 529 "Об утверждении приоритетных направлений научно-технологического развития и перечня важнейших наукоемких технологий" (http://publication.pravo.gov.ru/document/0001202406180018 ?index=1).

- Важнейшие наукоемкие технологии: критические технологии и сквозные технологии в соответствии с Указом Президента РФ от 18 июня 2024 г. № 529 "Об утверждении приоритетных направлений научно-технологического развития и перечня важнейших наукоемких технологий" (http://publication.pravo.gov.ru/document/0001202406180018 ?index=1)

- Описание результатов работы по проекту за год в доступной форме - 2-3 абзаца.

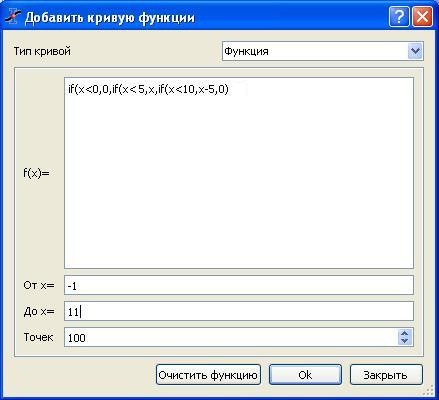

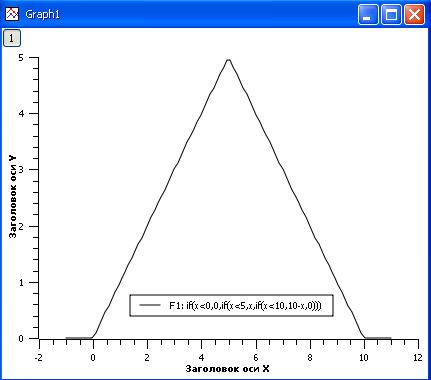

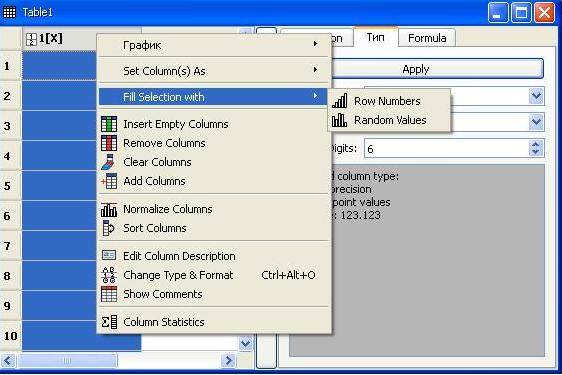

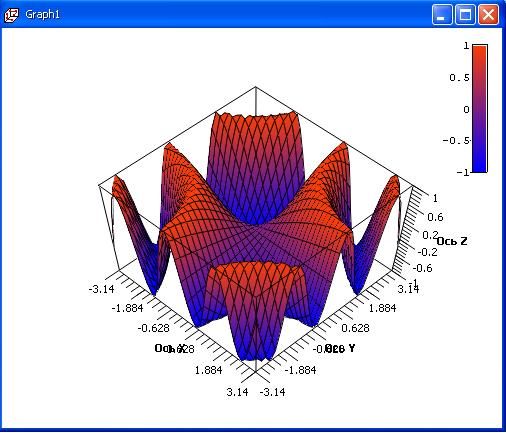

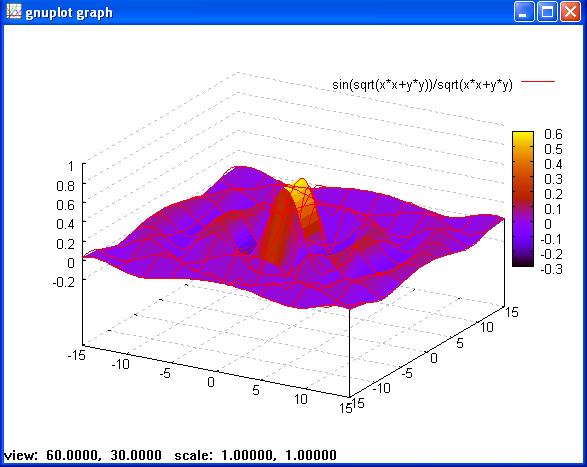

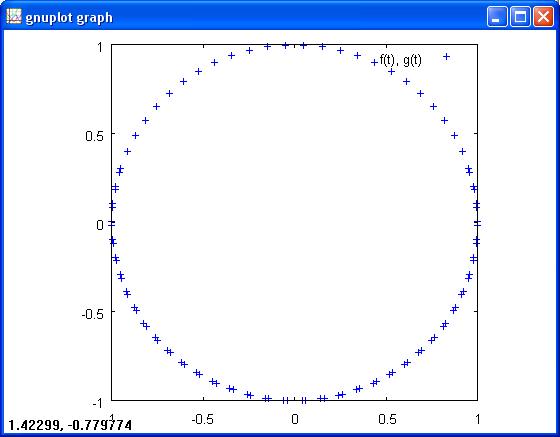

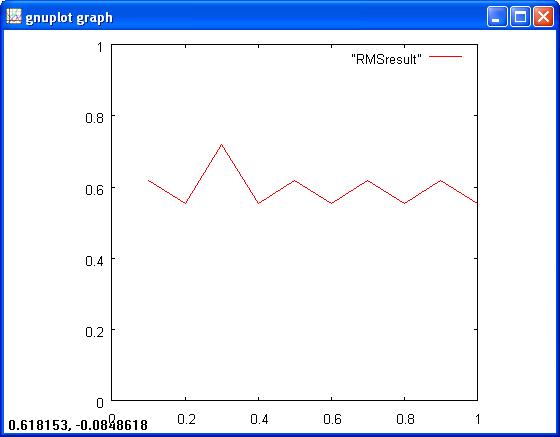

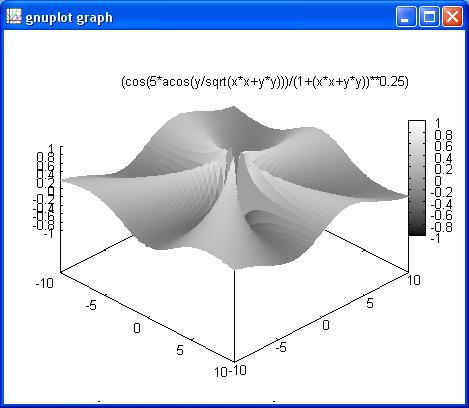

- 2-3 ярких, показательных иллюстрации работы (картинки/схемы/графика/фото, если таковые имеются), которые необходимо вставить в текст, а также представить в виде отдельных графических файлов высокого качества.

Имя файла: Отчет_<сокращенное название института>_<наименование НИР>_<номер рисунка по теме>.jpg. - (По желанию) Краткая, не более половины страницы, аннотация работы на английском языке .

- Список публикаций, в которых есть ссылки на то, что при работе по проекту был использован суперкомпьютер «Уран» ИММ УрО РАН (за текущий год по данному проекту), в формате: № п/п |Наименование|DOI публикации|Авторы|Издание(полная библ. информация)| ISSN издания| IF и номер квартиля в Web of Science | IF в SCOPUS | ИФ в РИНЦ| Уровень в «Белом списке» научных журналов| ВАК РФ| Аннотация.

Сокращения:

DOI публикации - цифровой идентификатор публикации;

ISSN - уникальный идентификатор периодического издания;

ИФ или IF (импа́кт-фа́ктор) — численный показатель важности научного журнала;

Уровень в «Белом списке» научных журналов - для определения воспользуйтесь ссылкой https://journalrank.rcsi.science/ru/

Для списка публикаций со ссылкой на использование суперкомпьютера «Уран» ИММ УрО РАН при работе по проектам за текущий год есть 2 таблицы.

Таблицу 1 заполнять обязательно.

Просьба: заполнить Таблицу 2, если у вас есть данные IF Scopus и Web of Science. - Сканы статей, указанных в списке публикаций по данной НИР, сделанные со страниц журнала, необходимо представить отдельными файлами в формате pdf. При отсутствии на странице названия журнала необходим скан титульного листа журнала.

- Список дипломных работ, защищенных кандидатских и докторских диссертаций в текущем году, подготовленных с использованием вычислительных средств СКЦ ИММ УрО РАН, в формате: Присвоенное звание | ФИО| Место работы| Должность| Возраст на момент защиты| Название работы| Дата защиты| Краткое описание полученных результатов.

- Список патентов, свидетельств на программу для ЭВМ и т.п., полученных по результатам работ, проведенных с использованием оборудования вычислительных средств СКЦ ИММ УрО РАН, в формате: № п/п | № в ЕГИСУ НИОКТР | Вид РИД |Авторы (ФИО, место работы, должность) | Реквизиты охранного документа (правообладатель, вид документа, номер, дата),

где РИД-результат интеллектуальной деятельности.

| Прикрепленный файл | Размер |

|---|---|

| 126 КБ |

Задачи, решаемые на кластере "Уран"

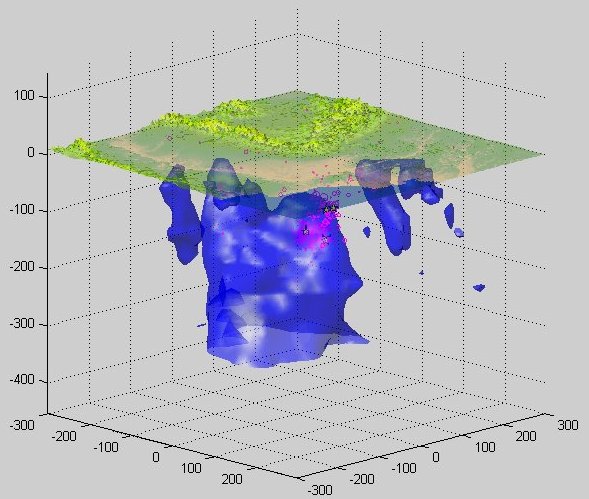

Моделирование задач геофизики на суперкомпьютере "Уран"

А.И. Короткий (1,2), И.А. Цепелев (1), А. Исмаил-заде (3,4), С. Хонда (5)

(1) Институт математики и механики УрО РАН, Екатеринбург, РОССИЯ

(2) Уральский федеральный университет, Екатеринбург, РОССИЯ

(3) Geophysikalisches Institut, Universitat Karlsruhe, GERMANY

(4) Institut de Physique du Globe de Paris, Paris, FRANCE

(5) Earthquake Research Institute, University of Tokyo, Tokyo, JAPAN

Цель исследования

Задача реконструкции внутреннего строения Земли состоит в качественной и количественной идентификации строения Земли и ее отдельных регионов на основе интерпретации геолого-геофизических данных (теплового, гравитационного, электромагнитного полей, сейсмичности, палео- и современной геодинамики). Моделирование данной задачи проводится в прямом и обратном временах. Для решения задач необходимо создание математических моделей глобальных процессов, проведение численных экспериментов на детальных расчетных сетках, установление соответствия построенных моделей результатам геодезических и геофизических измерений современного состояния и динамики земных недр. Для эффективной компьютерной реализации требуется использование суперкомпьютеров большой мощности.

Моделирование геофизических процессов на ЭВМ позволит получить фундаментальные знания в области реконструкции физических параметров, обоснования и численного решения задач прогнозирования и оценки параметров геологических систем. Использование ЭВМ в этом направлении приведет к реальному сокращению затрат на эти исследования...

| Прикрепленный файл | Размер |

|---|---|

| 1.34 МБ | |

| 4.28 МБ |

Моделирование погружения осколка континентальной плиты в районе юго-восточных Карпат

А.И.Короткий (1,2), И.А.Цепелев (1), А.Т.Исмаил-заде (3,4), Дж.Шуберт (5)

(1) Институт математики и механики УрО РАН, Екатеринбург, РОССИЯ

(2) Уральский федеральный университет, Екатеринбург, РОССИЯ

(3) Geophysikalisches Institut, Universitat Karlsruhe, GERMANY

(4) Institut de Physique du Globe de Paris, Paris, FRANCE

(5) Institute of Geophysics and Planetary Physics, University of California, USA

Основные научные цели исследования:

на основе обработки реальных геолого-физических данных для географического региона юго-восточных Карпат исследовать эволюцию погружения тектонической плиты в заданной области, изучить механизмы образования тектонических напряжений в коре Земли, которые приводят к землетрясениям в данном регионе.

| Прикрепленный файл | Размер |

|---|---|

| 1.44 МБ |

Компьютерное моделирование стеклования в системе коллапсирующих сфер

Р.Е. Рыльцев1, Н.М. Щелкачев1,2, В.Н. Рыжов3

1 – Институт Металлургии УрО РАН

2 – Институт теоретической физики им. Л.Д. Ландау

3 – Институт физики высоких давлений им. Л.Ф. Верещагина

Получение аморфных материалов с заданными свойствами является важнейшей практической задачей. Ее решение невозможно без всестороннего изучения физических процессов и механизмов стеклования, что обуславливает также и фундаментальный интерес к данной проблеме. В силу отсутствия строгой теории и сложности аналитического описания процесса стеклования основным инструментов теоретического исследования здесь является компьютерное моделирование методом молекулярной динамики.

Основной целью данной работы является исследования стеклования методами молекулярной динамики. Решение этой задачи требует больших затрат машинного времени в силу необходимости рассматривать большие системы и по причине медленной релаксации системы в окрестности температуры стеклования. Это заставляет искать оптимальные модельные системы, которые должны быть достаточно простыми, но вместе с тем описывать свойства некоторого класса конкретных систем. Одной из таких систем является система коллапсирующих сфер, описываемых эффективным парным потенциалом с отрицательной кривизной в области отталкивания. Такие потенциалы используются в качестве простейших моделей систем с направленными связями типа воды, кремнезема и др.

Проведено компьютерное моделирование структурных и динамических свойств системы коллапсирующих сфер. Впервые для однокомпонентных систем с изотропными потенциалами обнаружено стеклование при квазиравновесном охлаждении, сопровождающееся рекордно большими отклонениями температурных зависимостей транспортных коэффициентов от закона Аррениуса. Найденная зависимость температуры стеклования от плотности имеет аномальный немонотонный характер, что объясняется квазибинарным поведением системы. Полученные результаты дают вклад в развитие общей теории стеклования, которая является фундаментальной основой для технологий изготовления аморфных сплавов и композитных нанокристаллических материалов с заданными свойствами.

| Прикрепленный файл | Размер |

|---|---|

| 497.73 КБ | |

| 3.17 МБ | |

| 363.94 КБ |

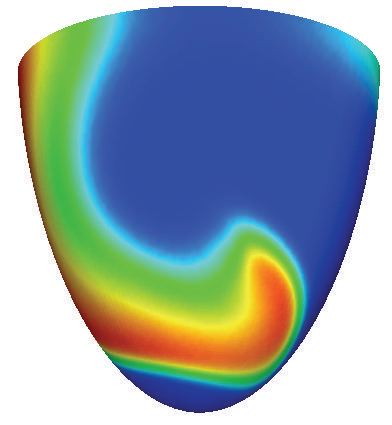

Моделирование свитковых волн электрического возбуждения в сердце

С.Ф.Правдин (1,2), А.В.Панфилов (3)

С.Ф.Правдин (1,2), А.В.Панфилов (3)

(1) Институт математики и механики УрО РАН, Екатеринбург, РОССИЯ

(2) Уральский федеральный университет, Екатеринбург, РОССИЯ

(3) Universiteit Gent, BELGIE

Основные научные цели исследования:

Изучить динамику трёхмерных свитковых волн электрического возбуждения в миокарде левого желудочка сердца, характерных для пароксизмальной тахикардии, в зависимости от толщины сердечной стенки, степени анизотропии миокарда, трансмурального угла вращения волокон и направления вращения волны. Выяснить условия распада волны (break-up), соответствующего переходу тахикардии в фибрилляцию желудочков.

В расчетах используется реалистичная ионная модель электрофизиологии кардиомиоцита "TNNP".

Кластер "Уран"

| Имя | Год | Кол-во ядер |

Процессор | Объем ОП |

Сеть | ОС | Пиковая производи- тельность (Tflop/s) |

Тест Linpack (Tflop/s) |

|---|---|---|---|---|---|---|---|---|

| "Уран" | 2008-2021 | 1734 CPU 149 GPU m2090 18 GPU k40m 8 GPU v100 (01.2021) |

Intel Xeon (2.2-3.1 ГГц) NVIDIA Tesla |

15 ТБ | Infiniband, GiEthernet |

Linux |

CPU 44.3 GPU 206.2 |

105.36 |

Адрес кластера "Уран" umt.imm.uran.ru

Аннотация

Суперкомпьютер «Уран» собран на базе Blade серверов фирмы Hewlett-Packard. Он состоит из 81 вычислительного узла, которые установлены в модулях с высокой плотностью упаковки.

Вычислительные узлы оснащены процессорами Intel Xeon, работающими на частотах 2.2-3.1 ГГц, 48-384 гигабайтами оперативной памяти и графическими ускорителями NVIDIA Tesla.

В общей сложности пользователям доступно 1542 вычислительных ядра CPU, 167 платы GPU и 13 Тбайт оперативной памяти. Система хранения суперкомпьютера «Уран» позволяет разместить до 140 Тбайт данных.

Для передачи данных между вычислительными узлами используется высокоскоростные сети Infiniband с пропускной способностью 20 Гбит/с и 100 Гбит/с. Доступ к суперкомпьютеру «Уран» осуществляется через городскую сеть УрО РАН в Екатеринбурге по технологии 10Gi Ethernet со скоростью 10 Гбит/c.

Для проведения научных и инженерных расчетов на суперкомпьютере установлено базовое программное обеспечение, включающее:

- Операционная система Linux;

- Система запуска задач Slurm;

- Языки программирования C, C++, Fortran;

- Компиляторы Intel, GNU, PGI;

- Библиотека Math Kernel Library (MKL) Intel;

- Реализации MPI: OpenMPI и MVAPICH2;

- Пакеты Matlab, ANSYS CFX Academic Research.

По заявкам пользователей на суперкомпьютере могут быть установлены компиляторы, библиотеки и пакеты программ, свободно распространяемые научным сообществом.

Краткое описание кластера

Кластер выполнен на базовых блоках (ББ) фирмы Hewlett-Packard . Каждый базовый блок объединяет вычислительные и коммуникационные модули.

Вычислительные узлы

Используются узлы нескольких типов, которые образуют основные разделы (partition) кластера. Внутри разделов (кроме debug) узлы связаны между собой высокоскоростной сетью Infiniband. Узлы разных разделов связаны между собой 1 Гбит/c Ethernet.

Раздел hiperf

1 узел tesla-v100 (2020.01)

- два 18-и ядерных процессора Intel(R) Xeon(R) Gold 6240 CPU @ 2.60GHz;

- оперативная память 384 GB;

- 8 GPU Nvidia Tesla V100 (32 ГБ Global Memory)

1 узел tesla-a100 (2022.06)

- два 24-х ядерных процессора Intel(R) Xeon(R) Gold 6240R CPU @ 2.40GHz;

- оперативная память 376 GB;

- 8 GPU Nvidia Tesla A100 (40 ГБ Global Memory)

1 узел tesla-a101 (2022.09)

- два 12-и ядерных процессора Intel(R) Xeon(R) Gold 6246 CPU @ 3.30GHz;

- оперативная память 251 GB;

- 2 GPU Nvidia Tesla A100 (40 ГБ Global Memory)

Раздел apollo

16 узлов apollo[1-16] (2017.02)

- два 18-и ядерных процессора Intel(R) Xeon(R) CPU E5-2697 v4 @ 2.30GHz;

- оперативная память 256 GB;

- кэш-память 45 MB SmartCache;

- локальный жесткий диск 1 TB

20 узлов apollo[17-36] (6 — 2019.12, 1 — 2020.01, 5 — 2020.01, 4 — 2021.11, 4 — 2022.10 )

- два 18-и ядерных процессора Intel(R) Xeon(R) Gold 6254 CPU @ 3.10GHz;

- оперативная память 384 GB;

Узлы раздела apollo объединены высокоскоростной сетью Infiniband нового поколения 100 Гбит/с.

Раздел all

20 узлов tesla[1-20]

- два 6-и ядерных процессора Intel® Xeon® X5675 (3.07GHz)

- оперативная память 48 GB

- кэш-память 2 x 12 MB Level 2 cache

- локальный жесткий диск 120 GB

10 узлов tesla[21-30]

- два 6-и ядерных процессора Intel® Xeon® X5675 (3.07GHz)

- оперативная память 192 GB

- кэш-память 2 x 12 MB Level 2 cache

- 8 GPU Tesla M2090 (6 ГБ Global Memory)

- локальный жесткий диск 400 GB

13 узлов tesla[33-45]

- два 8-и ядерных процессора Intel® Xeon® E5-2660 (2.2 GHz)

- оперативная память 96 GB

- кэш-память 2 x 20 MB Level 2 cache

- 8 GPU Tesla M2090 (6 ГБ Global Memory)

- локальный жесткий диск 400 GB

5 узлов tesla[48-52]

- два 8-и ядерных процессора Intel® Xeon® E5-2650 (2.6 GHz)

- оперативная память 64 GB

- кэш-память 2 x 20 MB Level 2 cache

- 3 GPU Tesla K40m (12 ГБ Global Memory)

- локальный жесткий диск 400 GB

Узлы раздела all объединены высокоскоростной сетью Infiniband 20 Гбит/с.

Раздел debug

4 узла tesla[31-32,46-47]

- два 8-и ядерных процессора Intel® Xeon® E5-2660 (2.2 GHz)

- оперативная память 96 GB

- кэш-память 2 x 20 MB Level 2 cache

- 8 GPU Tesla M2090 (6 ГБ Global Memory)

- локальный жесткий диск 400 GB

Узлы раздела debug объединены сетью 1 Гбит/c Ethernet.

Коммуникационная счетная среда

В качестве MPI – интерконнекта использована хорошо себя зарекомендовавшая технология Infiniband (IB). В качестве коммутатора IB использован 144 – портовый коммутатор Qlogic 9120.

Коммуникационная среда ввода/вывода

В качестве I/O – интерконнекта использована выделенная сеть Gigabit Ethernet. Сеть имеет двухуровневую структуру. Первый уровень организован на коммутирующих модулях GbE2c Ethernet Blade Switch for HP c-Class BladeSystem, установленных в шасси ББ. К коммутирующему модулю каждого ББ внутренними гигабитными каналами подключены вычислительные модули и модуль управления. Коммутирующий модуль каждого ББ подключен к коммутатору Ethernet HP ProCurve Switch 4208v1-192. К нему подключены все ВМ, порты Host – машин, консоль управления и мониторинга.

Управляющий сервер (HOST- машина)

Управляющий сервер ВС - HP DL180G5 на основе процессоров Intel Xeon 5430.

Управляющий сервер содержит:

- два четырёхъядерных процессора с тактовой частотой 2,6 ГГц;

- 16 ГБ оперативной памяти;

- дисковую подсистему RAID5, состоящую из 5 дисков SATA объемом 500 ГБ каждый ;

- 10/100/1000 Base-T Ethernet интерфейс;

- видеоадаптер, порт USB 2, порты мыши, клавиатуры.

| Прикрепленный файл | Размер |

|---|---|

| 60.64 КБ |

Начинающим

Вычислительные ресурсы для учреждений УрО РАН предоставляются на основе договоров, заключаемых в соответствии с Положение о вычислительном Центре коллективного пользования ИММ УрО РАН от 18.01.2016. Стоимость вычислительных услуг для всех остальных организаций договорная.

Cотрудникам организаций, уже заключивших договор с ИММ УрО РАН, чтобы стать пользователями суперЭВМ, необходимо:

- Ознакомиться с правилами использования вычислительных ресурсов ИММ УрО РАН.

- Оформить заявку на регистрацию пользователей.

- Получить от администраторов login (имя пользователя) и пароль для доступа на серверы.

Для работы на суперЭВМ с персонального компьютера пользователю необходимо установить на компьютере программы, которые обеспечат :

1) удаленный доступ к командной строке сервера для компиляции и запуска задач;

2) возможность обмена файлами между компьютером и сервером;

3) удобный графический интерфейс.

Начинающим пользователям полезно ознакомиться со Схемой работы на кластере.

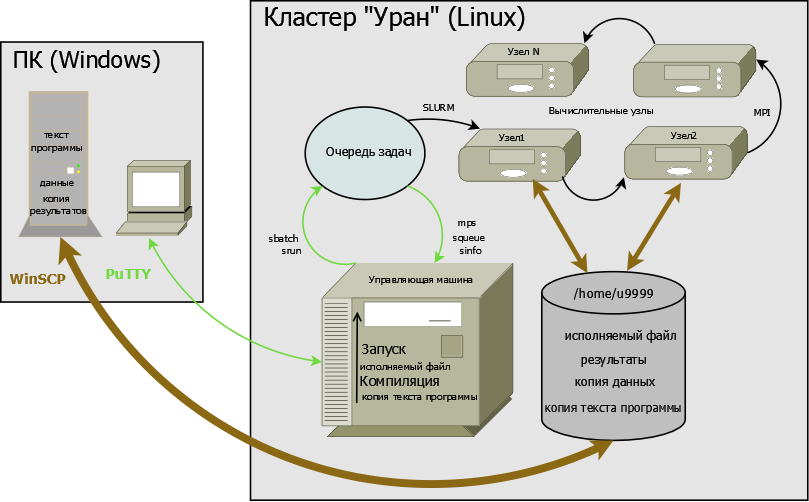

Схема работы на кластере

Схема работы на кластере проиллюстрирована ниже на примере кластера "Уран" с использованием программ WinSCP и PuTTY (см. Программы удаленного доступа).

Для вычислений на компьютере или кластере нужен исполняемый файл программы и, как правило, исходные данные. Поскольку на компьютере пользователя обычно установлена операционная система Windows, а на кластере - Linux (разновидность UNIX), то для счета на кластере необходимо получить исполняемый файл с помощью одного из компиляторов кластера. Следовательно, на кластер должен быть переписан текст программы.

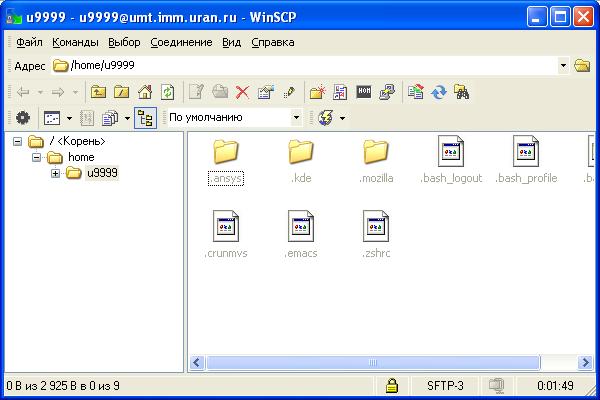

Для удаленного копирования файлов используется программа WinSCP.

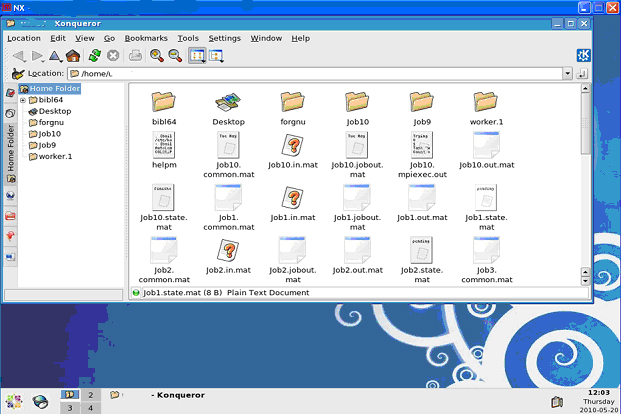

Пользователь копирует файлы (текст программы, исходные данные) с персонального компьютера в свой домашний каталог на кластере:

на рисунке это копирование в /home/u9999, где u9999 - имя (идентификатор, login) пользователя на кластере.

Компиляция программ и запуск задач на счет осуществляются после входа на кластер через программу удалённого доступа PuTTY. Набирая в окне PuTTY соответствующие команды, пользователь выполняет на управляющей машине (хосте) нужные ему действия, в частности, компиляцию и запуск задач на кластере. При этом запуск задачи осуществляется с помощью постановки её в очередь на счет. Ведением очереди и стартом задач на вычислительных узлах занимается система SLURM. Во время счета параллельные вычислительные процессы задачи могут обмениваться данными по коммуникационной сети и имеют доступ к домашнему каталогу.

Пользователь в любой момент может получить информацию о своих задачах в очереди и о доступных ресурсах кластера.

Ускорение вычислений достигается лишь после преобразования последовательной программы в параллельную, обычно с применением стандартов MPI и OpenMP. Запуск задач на кластере осуществляется с учетом особенностей программ, в частности, с учетом использования MPI и/или OpenMP. Для отладки полезно запустить на кластере последовательный тестовый вариант программы. Так же как параллельные, последовательные (однопроцессные) программы должны запускаться путем постановки в очередь.

Для работы на кластере полезно ознакомиться с базовыми командами ОС UNIX.

Внимание! По правилам пользования вычислительным кластером "Уран" счетные задачи можно запускать лишь на вычислительных узлах кластера, используя команды системы SLURM srun, sbatch или упрощенную команду mqrun (см. раздел Запуск задач на кластере). Такое ограничение связано с тем, что исполняющиеся на хост-машине процессы счетного характера на длительное время занимают процессорные ядра хост-машины, затрудняя работу с кластером всех остальных пользователей.

Вход на кластер по секретному ключу

- Доступ по ключу

- Использование агента аутентификации

- Генерация ключей в UNIX

- Совместное использование ключа и пароля

- Основные ссылки

Для входа на кластер пользователь должен иметь логин (имя пользователя) и для аутентификации (подтверждения подлинности) ключ или пароль (password).

Поскольку использование ключа обеспечивает большую конфиденциальность и дает возможность избавиться от подтверждения пароля для операций типа scp (удалённого копирования файлов), доступ по ключу рассматривается в дальнейшем как более предпочтительный.

Поэтому первоначально, а также при утере пароля или ключа для обеспечения доступа к кластеру необходимо создать ключи, как это описано ниже.

Для входа на кластер из ОС Windows можно воспользоваться программой PuTTY (см. Программы удаленного доступа).

Для организации доступа по ключу требуется выполнить следующую последовательность действий.

1. Сгенерировать и сохранить на своем компьютере приватный (секретный) и публичный ключи,

используя программу PuTTYgen из поставки PuTTY, как проиллюстрировано в инструкции [1]. При этом публичный ключ следует сохранить в файле Блокнота, копируя текст из PuTTYgen: начиная с типа ключа 'ssh-rsa' и заканчивая знаками '==' и комментарием с датой вида 'rsa-key-20150421'.

Секретный ключ рекомендуется зашифровать кодовой фразой (паролем секретного ключа, passphrase) и хранить в безопасном месте.

2. Добавить публичный ключ в файл ~/.ssh.authorized_keys каталога на сервере ( '~’ обозначает домашний каталог пользователя). Пользователь может сделать это самостоятельно (если у него есть доступ на кластер по паролю или другому ключу, см. [1]) или отправить файл с публичным ключом администратору кластера на адрес parallel@imm.uran.ru. Администратор кластера установит публичный ключ и сообщит об этом пользователю.

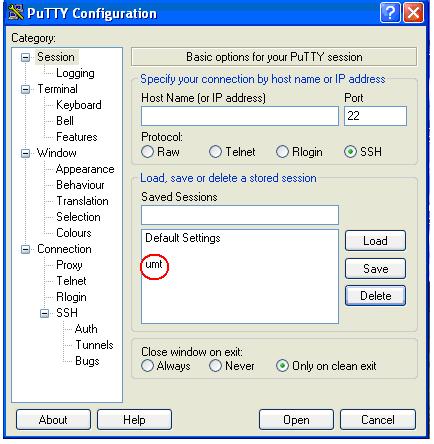

3. Создать в PuTTY именованную сессию (Session) для работы на кластере с доступом по ключу, для чего вставить путь к секретному ключу в разделе Connection->SSH->Auth, вернуться в раздел Session и, заполнив поля Host Name и Saved Sessions значениями, например umt.imm.uran.ru и umt, сохранить настройки (см. [1]).

После этого работа с кластером может быть инициирована двойным нажатием на имени созданной сессии.

Использование агента аутентификации

Если секретный ключ защищён кодовой фразой (passphrase), то запуск агента аутентификации, программы Pageant из поставки PuTTY (см. инструкцию [2]), избавляет от ввода passphrase при повторном соединении по ключу с кластером на период времени до завершения работы агента.

Pageant можно запустить, например, двойным кликом на секретном ключе и набором его кодовой фразы (если есть). В результате в системной области панели задач (внизу справа ) появится иконка Pageant.

Далее (при каждом входе на кластер) правой кнопкой мыши открываем меню и выбираем для запуска нужную сессию (umt).

В UNIX-системах для генерации ключей используется утилита ssh-keygen,

создающая два файла: ~/.ssh/id_rsa и ~/.ssh/id_rsa.pub (имена по умолчанию),

агент аутентификации запускается с помощью утилиты ssh-agent.

Совместное использование ключа и пароля

Имея доступ по ключу, пользователь при необходимости может запросить пароль у администратора кластера. Администратор создает пароль (password) и кладет его в домашний каталог пользователя, сообщая ему об этом.

Пользователь всегда может изменить пароль командой passwd.

Надо иметь в виду, что при входе на кластер сначала делается попытка пройти аутентификацию по ключу, а в случае неудачи - по паролю.

В PuTTY удобнее иметь разные сессии для доступа по ключу или паролю.

При доступе по паролю вводить password требуется всегда. В случае использования ключа кодовая фраза (passphrase) запрашивается (если есть), но возможно только один раз и возможно для доступа ко многим системам. Поэтому кодовая фраза может быть более сложной, что повышает безопасность, не слишком усложняя работу пользователя.

1. Настройка аутентификации по ключу в PuTTY

2. Работа с агентом аутентификации в PuTTY

Программы удаленного доступа

Для работы на суперЭВМ с персонального компьютера пользователю необходимо установить программы на компьютере, которые обеспечат

удаленный доступ к командной строке сервера для компиляции программ и запуска задач,

возможность обмена файлами между компьютером и сервером

и позволят использовать удобный графический интерфейс.

1. Удаленный доступ к командной строке сервера

Доступ к серверам осуществляется через протокол SSH (собственно SSH – « secure shell »). Для работы с командной строкой рекомендуется программа PuTTY. Эта программа позволяет единожды ввести адрес сервера и, в дальнейшем, выбирать его из списка сессий. В настройках PuTTY необходимо указать протокол SSH. При первом соединении с сервером программа выдает предупреждение о том, что ключ шифрования сервера ранее не использовался, и предлагает его сохранить или отвергнуть (продолжить сеанс или прервать). Естественно надо выбрать продолжение сеанса.

Полезно более подробно ознакомиться с установкой и некоторыми настройками программы PuTTY.

Пример диалога при входе на сервер UM16 с именем xxxxx с компьютера ada.imm.uran.ru:

login as: xxxxx Password: (ввести пароль) Last login: Tue Sep 6 16:31:23 2005 from ada.imm.uran.ru

Вы можете изменить свой пароль в любое время, набрав команду passwd, например:

[~@um16]:passwd Password for xxxxx@IMM.URAN.RU: (наберите здесь свой текущий пароль) Enter new password: (наберите новый пароль) Enter it again: (повторите новый пароль) Password changed. (успешная смена пароля)

Для того чтобы защитить свою учетную запись, придерживайтесь следующих рекомендаций:

- используйте пароль не менее, чем из 6 букв и цифр и храните его в секрете;

- один раз в полгода меняйте свой пароль;

- никогда не оставляйте активный терминал без внимания, всегда выходите (logout) со своего терминала (заканчивайте сеанс) прежде, чем покинуть его;

- обязательно сообщайте о любом неправильном использовании или злоупотреблении системному администратору, иначе доступ к серверу будет закрыт.

Для того, чтобы завершить сеанс работы на сервере, выполните команду logout.

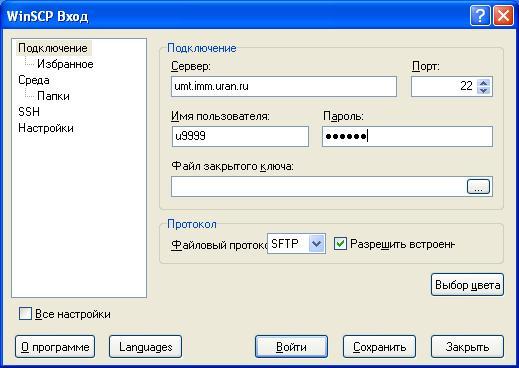

2. Обмен файлами между компьютером и сервером

Для обмена файлами между компьютером и сервером рекомендуется использовать программу WinSCP.

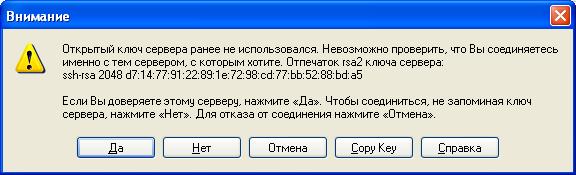

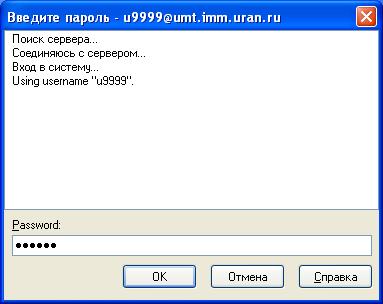

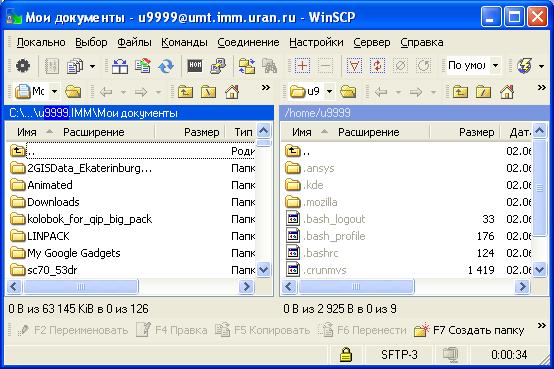

При копировании файлов (протоколы SCP – “secure copy ” и SFTP – “ secure ftp ”) в настройках WinSCP рекомендуется выбрать протокол SFTP. Программа WinSCP позволяет сохранить имя пользователя и пароль. При первом соединении с сервером программа выдает предупреждение о том, что ключ шифрования сервера ранее не использовался, и предлагает его сохранить или отвергнуть (продолжить сеанс или прервать). Естественно, надо выбрать продолжение сеанса. Программа WinSCP может использоваться как самостоятельное приложение и как плагин для других программ проводников, например для Far Commander.

Тексты программ и данные для задачи можно записать в отдельный каталог на сервере, тогда вся информация по этой задаче будет сохраняться в этом каталоге (объектные модули после трансляции текстов программ, файл с сообщениями об ошибках, выходные файлы).

На сервере существует понятиe домашнего каталога, это каталог с именем /home/имя_пользователя. При работе с командной строкой этот каталог становится текущим после установления терминального соединения. Программа WinSCP может запоминать последний посещенный в предыдущей сессии каталог. Поэтому важно следить, в какой каталог производится копирование.

После копирования необходимо перейти в рабочий каталог, выполнить компиляцию программы и ее запуск.

Полезно ознакомиться с информацией об установке и некоторых настройках программы WinSCP.

3. Графический интерфейс

Для работы с сервером удобно использовать графический интерфейс. В настоящее время предпочитаемой программой для подключения к рабочему столу кластера в графическом режиме является X2Go Client (замена программы NX Client, которая больше недоступна для скачивания с сайта производителя).

Для удалённого запуска графических Linux программ с использованием протокола X-Window предназначена и программа MobaXterm_vx.x.exe.

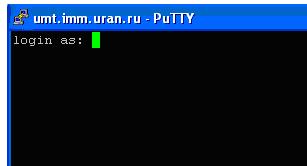

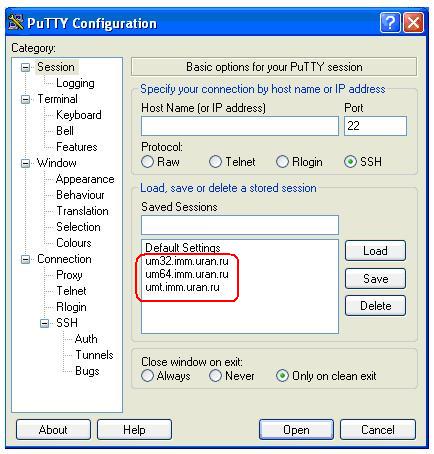

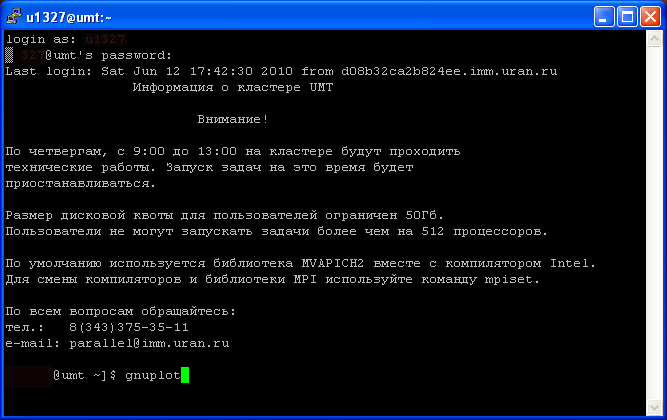

Установка и настройка программы PuTTY

Для установки программы PuTTY на свой компьютер воспользуйтесь ресурсами http://www.chiark.greenend.org.uk/~sgtatham/putty/download.html

Чтобы войти на нужный кластер, необходимо:

- Запустить программу PuTTY.

- В открытом окне ввести имя кластера(Host Name).

- Выполнить команду OPEN.

Откроется окно , в котором после ввода логина и пароля пользователь может работать на кластере из командной строки или используя Midnight Commander.

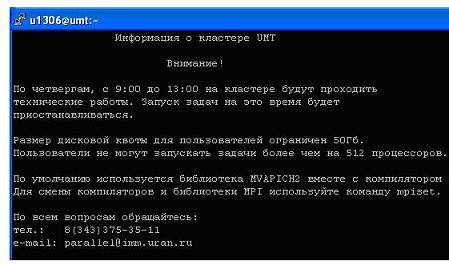

В начале сеанса выдается информация о кластере .

Для удобства работы можно выполнить некоторые настройки и сохранить их для дальнейших сеансов.

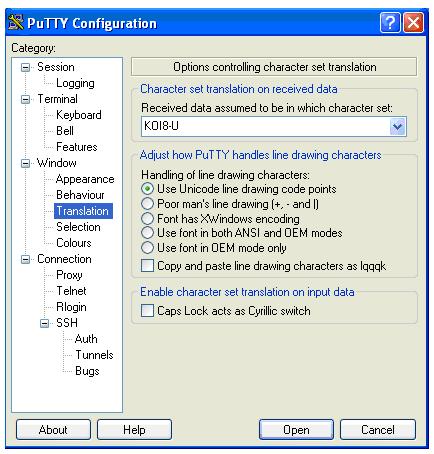

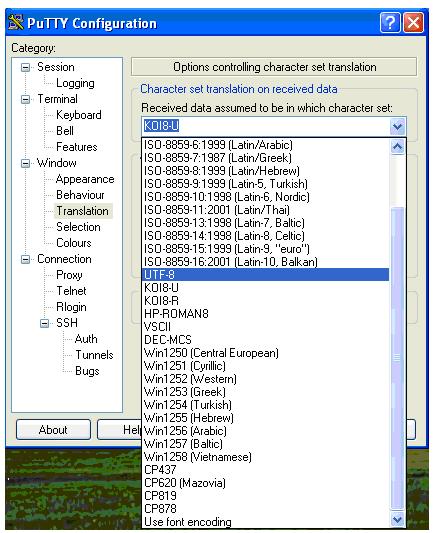

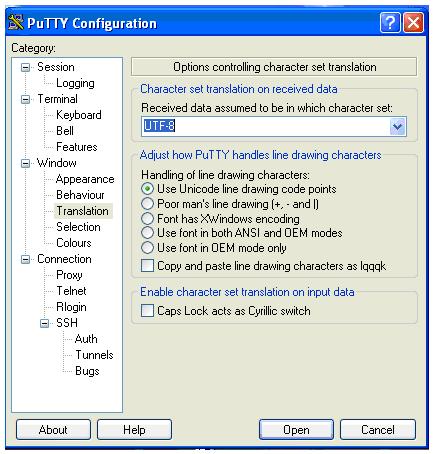

Например, чтобы при входе на кластер пользователь мог прочитать вводный текст на русском языке, необходимо выбрать кодировку UTF – 8 и сохранить данную настройку, проделав следующие шаги.

Открыть окно PuTTY

Выбрать раздел Translation.

Выбрать кодировку UTF – 8.

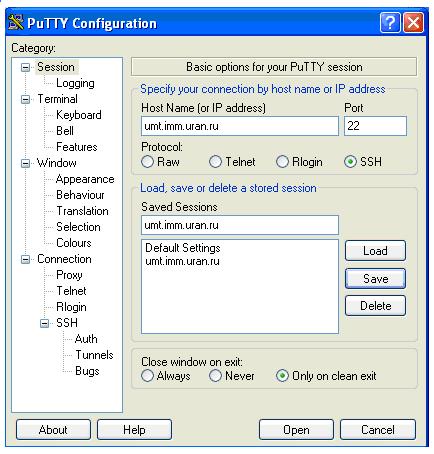

Перейти к разделу Session.

Ввести имя кластера в окнах Host Name и Saved Sessions.

Нажать клавишу Save (сохранить)

и затем Open .

В дальнейшем для начала сеанса на кластере достаточно выделить нужную сессию и нажать Load, затем Open или выполнить двойной клик на имени сессии.

ВНИМАНИЕ!

Чтобы настроить нужную кодировку при работе на другом кластере, необходимо повторить все шаги заново для этого кластера.

В итоге при запуске PuTTY будет открываться окно

Пользователю достаточно выбрать нужный кластер и начать работу.

Желаем удачи!

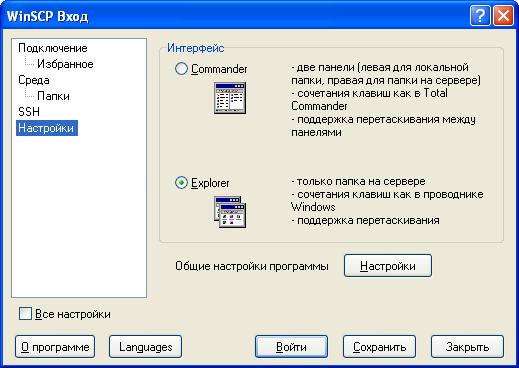

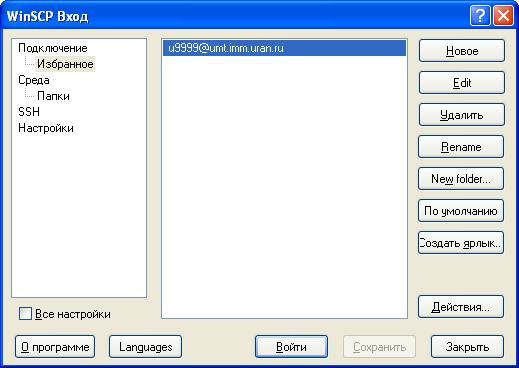

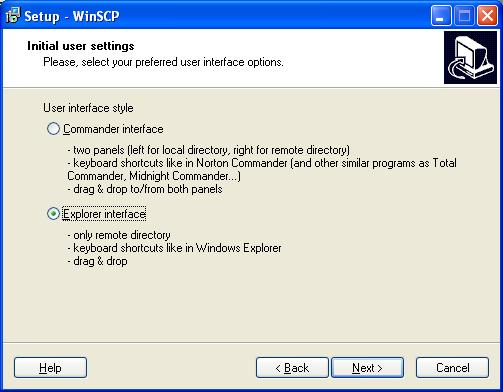

Установка и некоторые настройки программы WinSCP

Программа WinSCP предназначена для удаленной работы с файлами на компьютерах/серверах.

Скачать программу можно с сайта разработчиков

Стиль графического интерфейса, выбранный в процессе установки, в дальнейшем можно изменить.

По окончании работы мастера установки на рабочем столе будет создан ярлык

и откроется окно,

Можно заново выбрать привычный для работы интерфейс.

Ввести необходимую информацию для подключения к выбранному серверу. Пароль лучше не вводить и не сохранять.

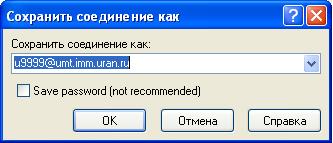

Сохранить эти настройки.

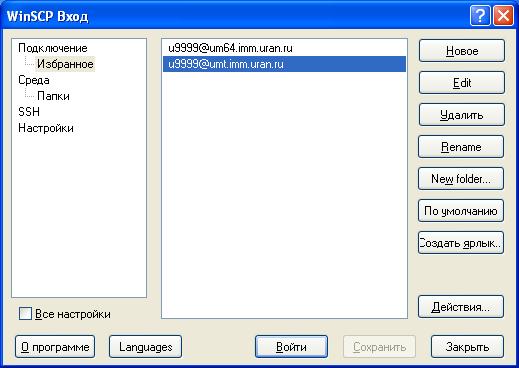

Аналогично можно выполнить и сохранить настройки для входа на другие серверы/кластеры.

Теперь остается выбрать сессию и выполнить ВОЙТИ.

Во время первого сеанса выдается диагностика,

выбрать ДА и продолжить работу.

Если пароль не был сохранен, то надо будет его ввести в новом окне.

Далее можно работать с файлами исходного компьютера и сервера, используя настроенный интерфейс.

Однопанельный в стиле "Проводника":

Либо двухпанельный в стиле "Командера":

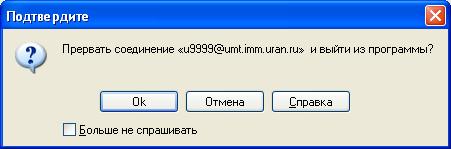

При закрытии окна рабочего инерфейса можно закончить сеанс работы.

Желаем удачи!

Mosh (Mobile Shell)

Одним из средств удаленного доступа к кластеру "Уран" является Mosh (Mobile Shel - мобильная оболочка). Mosh является альтернативой для интерактивного терминала SSH. Реализации Mosh - доступны для Windows, Linux, Android и iOS. Особенностью Mosh - является то, что она позволяет получить доступ к серверу с мобильного телефона при плохом качестве связи. Mosh поддерживает кратковременные перерывы связи и позволяет вводить команды в командной строке даже тогда, когда связь временно отсутствует. После восстановления связи, команды передаются на сервер, а экран обновляется, чтобы показать последние сообщения.

В Linux клиентская часть Mosh устанавливается стандартными средствами установки программ. Для Android необходимо установить эмулятор командной строки - termux, и выполнить в нем команду apt install mosh. В Windows и ChromeOS Mosh устанавливается как расширение браузера Chtome.

ВНИМАНИЕ. Закрытие окна приложения Mosh в любой ОС, не завершает сеанс на сервере, но делает его недоступным. Для корректного завершения работу используйте команду exit. Удаление незавершенных сеансов на сервере описано ниже.

Описание установки Mosh из браузера Google Chrome по шагам:

Шаг № 1.

Вызываем Google Chrome и входим в настройки через кнопку «Настройки и управление Google Chrome»

Шаг № 2

В открывшемся окне выбираем «Дополнительные инструменты/Расширения» или «Настройки/Расширения» (в зависимости от версии Chrome);

Шаг № 3.

Вызвав «Расширения» и не обнаружив MOSH, идем в «Интернет магазин Chrom»

Шаг № 4.

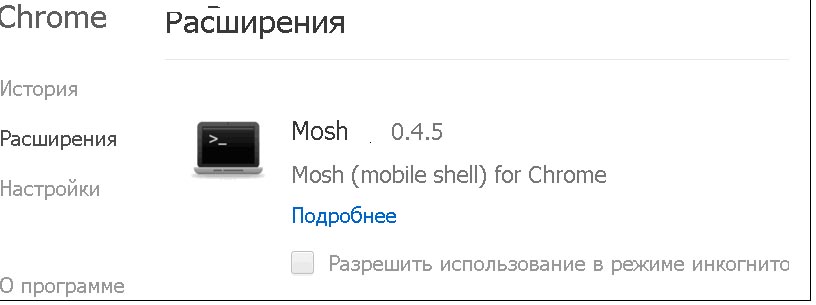

Mosh появился в «Расширения».

Вы можете работать прямо в браузере, если дважды щелкните на иконке с изображением Mosh ![]() , или установить приложение в "Главное меню" компьютера и запускать Mosh из меню кнопки "Пуск".

, или установить приложение в "Главное меню" компьютера и запускать Mosh из меню кнопки "Пуск".

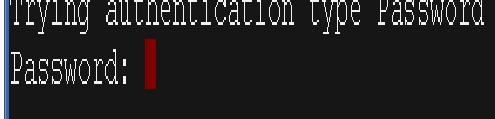

Шаг № 5.

Произошел вызов Mosh.

Заполните текстовые поля для Username (ваш логин) и Hostname (имя хоста umt.imm.uran.ru), затем нажмите Connect.

Шаг № 6

После ввода пароля и появления приглашения командной строки можно начинать работать!

Несколько полезны советов.

Как добавить закрытый ключ.

Закрытый ключ добавляется при запуске Mosh по ссылке «Add ssh key». После задания ключа работа с Mosh будет происходить без запроса пароля. В диалоговое окно вставляется текст секретного ключа, который можно взять из файла ~/.ssh/id_rsa на сервере. Кнопка Save сохраняет ключ в постоянном хранилище браузера.

Если повторно выбрать «Add ssh key», то поле для ключа будет содержать напоминание о том, что ключ уже был задан. Если ключ ещё нужен, то можно закрыть окно крестиком. Если нажать кнопку Save не вводя новый ключ, то текущий ключ удалится из памяти.

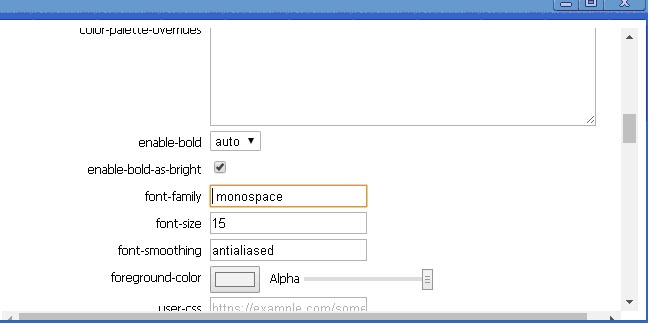

Как задать отображение русских букв в сеансе работы с Mosh.

Чтобы правильно отображать русские буквы необходимо в Preferences, в текстовом поле для «font-family» выбрать шрифт «monospase» (из списка удалить все кроме «monospase.

Как выбросить все сеансы работы c Mosh.

В командной строке выполните команду:

killall -KILL mosh-serverОсторожно. Если вы работаете через Mosh, то закроется и текущий сеанс.

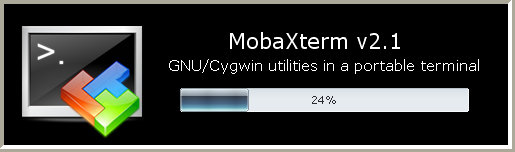

Использование MobаXterm

Программа MobaXterm_vx.x.exe объединяет в себе текстовый терминал и средства для удалённого запуска графических Linux программ с использованием протокола X-Window.

Программа распространяется в виде переносимой (portable) версии в архиве с именем MobaXterm_Portable_vx.x.zip ( x.x - это номер версии), или в виде архива с инсталлятором MobaXterm_Installer_vx.x.zip, которые можно бесплатно получить на сайте разработчика.

Запустите MobaXterm_vx.x.exe :

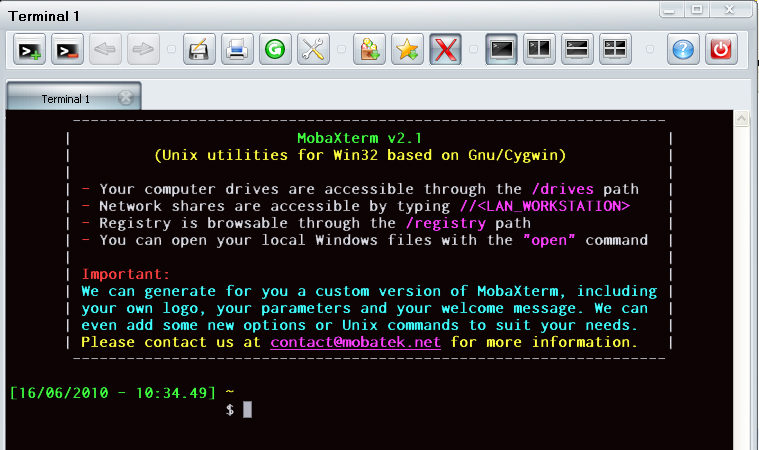

Рисунки №1 и №2 демонстрируют вызов программы MobaXterm_vx.x.exe, которая открывает терминал.

В командной строке наберите ssh umt.imm.uran.ru и введите имя пользователя и пароль. Теперь можно запускать графические приложения, например matlab. При запуске в конец строки можно добавить символ &, что позволит освободить командную строку для ввода последующих команд:

matlab &

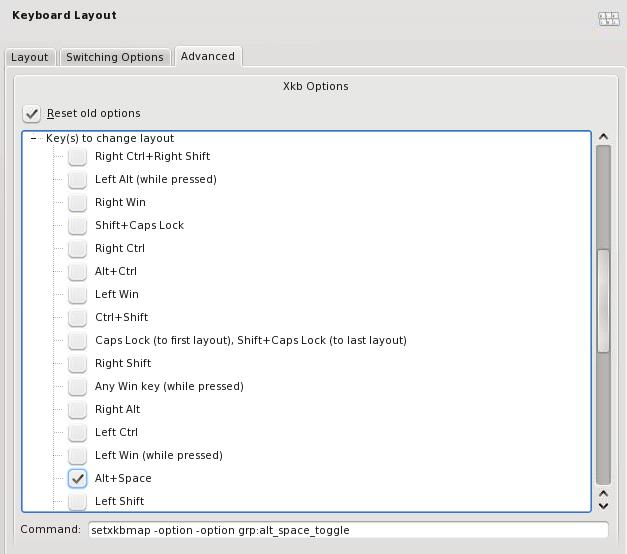

Переключение русской раскладки в графических приложениях

На графические приложения XWindow переключение раскладки в текстовой консоли никак не влияет. Чтобы в графических приложениях можно было переключать раскладку надо до их запуска в консоли на удалённой машине выполнить команду, которая назначит переключение на сочетание Левый Alt+ Shift.

setxkbmap -layout us,ru -variant winkeys -option grp:alt_shift_toggle

Для удобства можно вставить эту команду на автовыполнение, например, добавив команду в файл ~/.bash_profile В версии MobaXterm Pro в расширенных настройках ssh-соединений команду можно прописать в поле Advanced SSH Settings -> Execute conmmand.

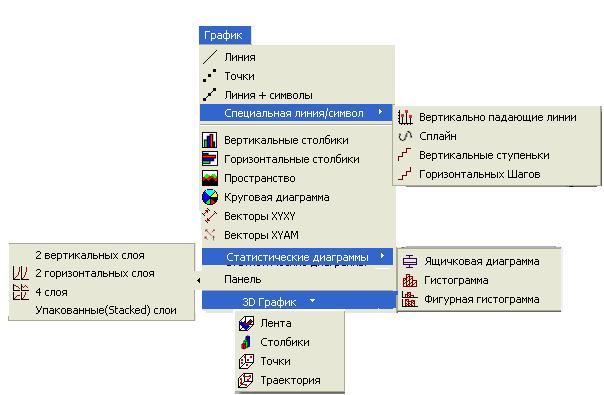

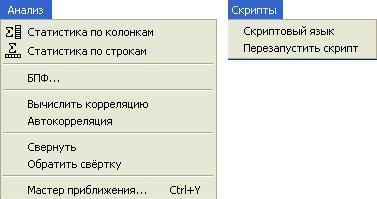

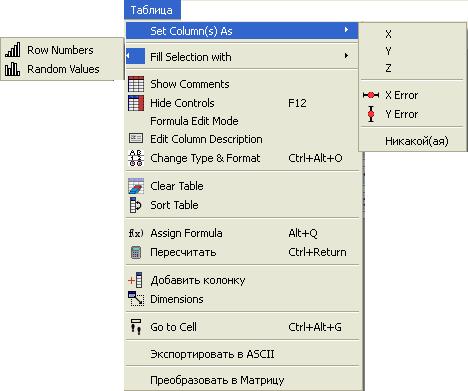

Программное обеспечение кластеров

Программное обеспечение кластера (трансляторы, библиотеки, пакеты прикладных программ и т. д.) обновляется и пополняется при выходе новых версий и по запросам пользователей (на адрес parallel@imm.uran.ru). Для компиляции программ доступны Intel компиляторы (бесплатно для некоммерческого использования в версиях Linux), свободно распространяемые компиляторы серии GCC (GNU Compiler Collection) и компиляторы Portland Group (PGI) с языков C , C++ , Fortran:

Intel (icc, icpc, ifort) GNU (gcc, g++, gfortran, g77) PGI (pgcc, pgcpp, pgf77, pgf90, pgf95)

Для трансляции Паскаль-программ можно воспользоваться Free Pascal Compiler (fpc).

Для организации межпроцессного взаимодействия можно использовать следующие библиотеки обмена сообщениями, реализующие стандарт MPI:

MVAPICH2 OpenMPI MPICH2

MPI (Message Passing Interface) ориентирован, прежде всего, на системы с распределенной памятью. Возможно распараллеливание программ и с помощью стандарта OpenMP (Open Multi-Processing), ориентированного на системы с общей памятью (см. Компиляция и запуск задач с OpenMP), а также стандартов CUDA (см. Использование CUDA) и OpenACC (Open Accelerators), нацеленных на использование графических процессоров (GPU). В компиляторах Portland Group реализованы как OpenMP, так и OpenACC (см. PGI Accelerator и OpenACC).

На кластере установлено программное обеспечение (ПО) фирмы Intel для профилировки и отладки – Intel Parallel Studio XE. Это ПО позволяет находить наиболее нагруженные места в приложении, подсчитывать степень параллельности программы, находить тупики и гонки в параллельных программах и т.д. Основные инструменты Advisor XE, Inspector XE и Vtune Amplifier XE находятся в соответствующих папках в каталоге /opt/intel (см. Инструменты Intel для профилировки и отладки).

Для смены компиляторов и библиотеки MPI, а также выбора других пакетов прикладных программ используйте модули установки переменных окружения .

Доступные пакеты

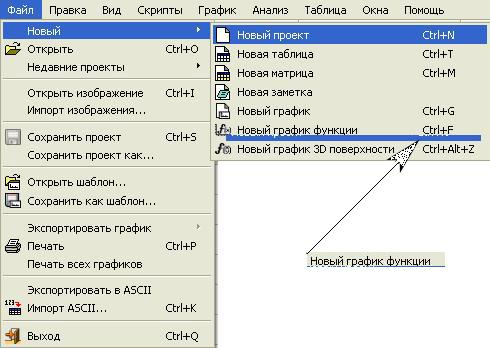

Имеются академические лицензии на пакеты Matlab и ANSYS CFX Academic Research.

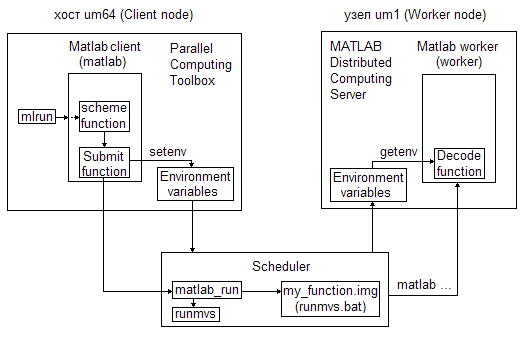

Информация о запуске программ из этих пакетов находится на страницах:

- Запуск параллельного Matlab - краткая инструкция

- Параллельный Matlab - полная инструкция

- Запуск программ из пакета ANSYS

Установлены по запросам и используются пакеты OpenFOAM, GAMESS, SIESTA, VASP и др.

Компиляция программ на кластере

Выбор среды компиляции

По умолчанию на каждом кластере установлен определенный набор компиляторов и библиотек. При входе на вычислитель каждому пользователю на экран выдается информация о некоторых установках по умолчанию, а также дополнительная служебная информация. Для выбора другого доступного ПО (компилятора, библиотеки обмена сообщениями, пакета прикладных программ) необходимо использовать модули установки переменных окружения. Для быстрого доступа к настройкам основных модулей можно воспользоваться командой mpiset (эта команда без параметров выдает текущие установки). В дальнейшем, при запуске задачи на счет, необходимо следить, чтобы выставленная конфигурация (например, через mpiset) совпадала при компиляции и при запуске.

О компиляции

Компиляция (в расчете на использование MPI) выполняется утилитами (командами):

mpiccдля программ на Сиmpicxxдля программ на C++mpif77для программ на Фортране 77mpif90для программ на Фортране 90

Они запускают компилятор, передавая ему дополнительные флаги, специфичные для MPI (ключ -show у этих утилит покажет, какая команда будет выполнена). Заметим, что компиляция программы (например исходной) без MPI может быть выполнена и обычными средствами со ссылкой на используемый компилятор (icc, gcc, pgcc, ...).

Для файлов на Си и C++ важно расширение имени файла: для языка Си это .c, для языка С++ это .cxx.

В командной строке задается список файлов, которые надо откомпилировать, и имя выходного файла. Для удобства желательно сообщения об ошибках компиляции перенаправить в файл. Например, если наш исполняемый файл должен называться outprog и собирается из файлов in1.c и in2.c, находящихся в каталоге proj, то необходимо выполнить следующие действия:

cd proj

mpicc –o outprog in1.c in2.c 2>errors.log

Сообщения об ошибках компиляции попадут в файл errors.log. В командной строке файл можно пролистать командой:

less errors.log

При пролистывании используются клавиши <Пробел> - следующая страница, b - предыдущая страница, q - выход из просмотра.

Подключение дополнительных библиотек обеспечивается добавлением опции –l<имя_библиотеки> в строку компиляции. Например, библиотека BLAS подключается так:

mpicc -o mytest mytest.c -L /usr/lib64/atlas -lcblas Если программа скомпилирована успешно, создастся файл mytest. Это можно посмотреть в WinSCP, не забыв обновить список файлов в окне, или в командной строке командой ls, которая выдает список файлов.

Компиляция программ, использующих для распараллеливания стандарты OpenMP, CUDA и OpenACC, а также особенности запуска таких программ рассмотрены в отдельных инструкциях, а именно:

Базовые команды ОС UNIX

Полная информация по UNIX командам и их параметрам выдается с помощью справочной командыman <имя команды> (q или Q - выход из man).

Далее под именем файла понимается простое, полное или относительное имя файла.

Простое имя файла - это имя файла в текущем (рабочем) каталоге (директории), например, mytest.

Полное (абсолютное) имя файла включает путь от корневого каталога, обозначаемого символом слеш (/), до каталога, содержащего файл, например, /home/u9999/dir/mytest

(слеш используется и как разделитель подкаталогов). Заметим, что /home/u9999 называется домашним каталогом пользователя u9999, домашний каталог обозначается тильдой (~).

Относительное имя файла содержит путь, который отсчитывается от текущего каталога и, следовательно, не начинается со слеша, например, dir1/mytest1.

Аналогичные пояснения относятся и к именам каталогов.

Следует иметь в виду, что большие и малые буквы в UNIX различаются.

При наборе команд и путей к файлу можно нажимать клавишу Tab для автодополнения имен; с помощью стрелок вверх и вниз можно выбрать ранее выполнявшуюся команду.

Ниже перечислены основные команды, с которыми полезно ознакомиться для работы в ОС UNIX:

pwd— выдать полный путь текущего каталога;mkdir <имя каталога>— создать каталог;cd <имя каталога> — сменить текущий каталог;cd .. — перейти в каталог уровнем выше ;cd— перейти в домашний каталог ;ls— распечатать содержимое текущего каталога;ls <имя каталога>— распечатать содержимое заданного каталога;rm -R <имя каталога>— удалить каталог со ВСЕМИ (опция-Rили-r) подкаталогами и файлами в нем;rm <имя файла>— удалить файл. Удалённый файл или каталог восстановить невозможно;cp <имя копируемого файла> <имя каталога, в который копируем>— копировать файл, напримерcp /home/u9999/mytest /home/u9999/dirmv <имя исходного файла> <имя каталога, в который перемещаем|имя файла, в который переименовываем>— переместить (переименовать) файл;cat <имя файла>— выдать содержимое файла на консоль;more, less— команды просмотра текста;gzip <имя файла>— сжать файл;gunzip <имя файла>.gz— расжать файл;tar <опции> <имя архива>.tar <имена файлов и каталогов>— работа с архиватором tar;size <имя файла с исполняемой программой>— выдать размер исполняемой программы в байтах, например$ size mytest text data bss dec hex filename 423017 12016 2128658400 2129093433 7ee76339 mytestгде

text- размер выполняемого кода,data- размер области инициализированных данных,bss- размер области неинициализированных данных,dec- общий размер программы,hex- общий размер программы в шестнадцатеричной системе,filename- имя программы. Если имя не указано, то будет использоваться a.out ;quotacheck(добавленная команда) позволяет узнать назначенный пользователю лимит дискового пространства и текущий объем его данных на диске, например$ quotacheck User: u9999 Used: 25.18GB Limit: 100.00GBdu <опции> <имя файла или каталога>— оценка места на диске, занимаемого файлом или каталогом, напримерdu -h mytestопция

-hиспользуется для более удобной формы выдачи (например, 1K 234M 2G), иначе по умолчанию в K, т.е. в Kбайтах (1 Кбайт=1024 байт); опция--siкак-h, но использует степень 1000, а не 1024.du -sh /home/u9999опция

-sиспользуется для выдачи суммарного места на диске, занимаемого пользователем u9999.

При отсутствии аргумента-имени выдается информация для текущего каталога:

du -sh— размер текущего каталога;

du -h— размер каталога и подкаталогов.find <имя каталога> -mtime <количество суток>— выдать имена всех файлов из <имя каталога> и его подкаталогов, которые изменялись в последние 24*(1+<количество суток>) часов;passwd— сменить пароль;uptime— получить время непрерывной работы сервера;exit— выйти из оболочки (или отключиться от машины).

Работа с архиватором tar

tar <опции> -f <имя архива.tar> <имена файлов и каталогов>Опции:

-f— указать имя файла архива. По умолчанию архив читается со стандартного ввода.-f -— явное задание чтения архива со стандартного ввода.-c— создать архив и записать в него файлы;-x— извлечь файлы из архива;-t— просмотреть содержимое архива; формат вывода аналогичен командеls –l; если имена файлов не указаны, то выводятся сведения обо всех файлах архива;-z— использовать программуgzipдля сжатия при архивировании файлов и для обратной распаковки архива перед извлечением из него файлов. Файлу сжатого архива принято давать с расширением.tar.gzили сокращённо.tgz;-j— аналогично-zтолько для программыbzip2и архивов с расширением.tar.bz2или.tbz; В современных версияхtarопции вызова программы сжатия-z,-jи т.п. указывать не обязательно — формат архива распознаётся автоматически.-p— при извлечении сохранить права доступа к файлам (по умолчанию сбрасываются права указанные в маскеumask);-v— выводить имена всех файлов, которые обрабатываются; если выбрана и опцияt, тоvдает больше информации о сохраненном файле, а не просто его имя.

При использовании нескольких опций знак «-» перед опциями не ставится.

Примеры

tar cf myarch.tar file1 file2 … filen — создание архива myarch.tar и запись в него перечисленных файлов;

tar cf myarch.tar mydir — создание архива из содержимого каталога mydir и всех его подкаталогов в файле myarch.tar;

tar xvpf myarch.tar— извлечение файлов из архива; при извлечении формируются и все подкаталоги; (f — ссылается на архивный файл, данная опция ставится последней в списке опций; p — заархивированные файлы будут восстановлены с изначальными правами доступа; v — выводятся имена извлекаемых файлов);

tar tf myarch.tar — выдача списка всех файлов, хранящихся в архиве myarch.tar;

tar cfz myarch.tgz mydir — архивация файлов с последующим сжатием архива программой gzip;

tar xfz myarch.tgz — вызов gzip для распаковки архива перед извлечением файлов;

zcat myarch.tgz | tar xf - — вызов внешней программы распаковки и передача распакованного архива через перенаправление стандартного ввода.

Архив

Установка и настройка NX клиента для Windows

- Дистрибутив NX клиента для Windows (nxclient-x.x.x-x.exe, где x.x.x-x - это номер версии) можно бесплатно получить на сайте разработчика www.nomachine.com в разделе

DOWNLOAD->Legacy NX 3.5.0 products (NX Client for Windows в списке NX Client products).

ВНИМАНИЕ! Версия 3 была полностью заменена версией 4, коммерческой.

Вместо программы NX Client можно использовать программу X2Go Client, а также MobaXterm_vx.x.exe.

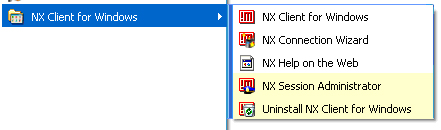

Чтобы начать процедуру установки запустите скаченный файл и проделайте весь путь инсталляции до добавления NX Client for Windows в меню:

-

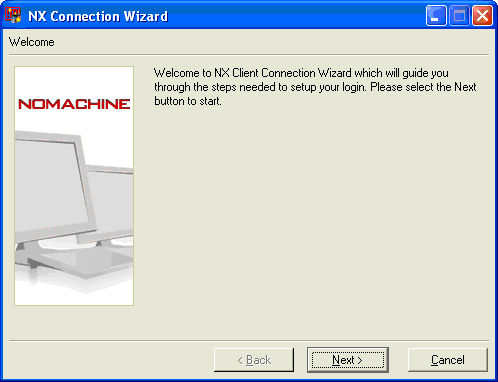

Запустите NX Connection Wizard (мастера настройки NX) для установки вашей сессии

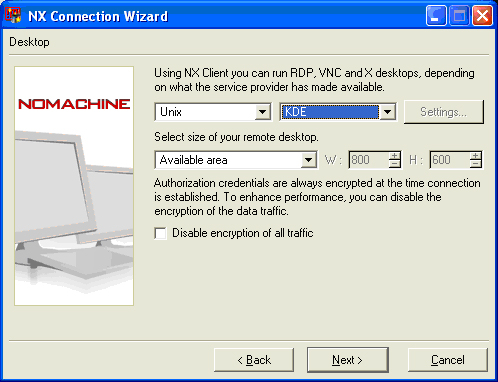

Диалоговое окно настройки сессии:

Далее:

Далее:

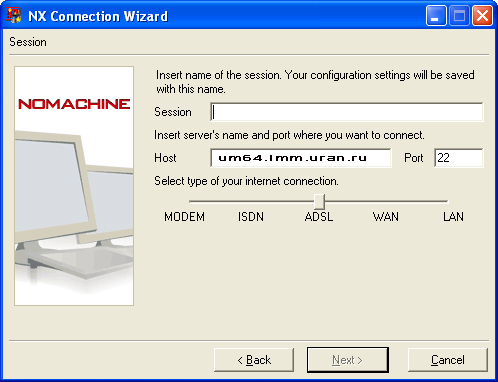

- • Host - имя сервера, к которому планируется подключение. Для кластера "Уран" это имя umt.imm.uran.ru .

- • Port- номер порта, на котором сервер ждет подключений - 22.

- • Ползунок с подписями "Modem", "ISDN", "ADSL", "WAN" и "LAN" - меняет степень сжатия данных в канале между сервером и клиентом и позволяет снизить объем трафика в канале связи "клиент <-> сервер". Выбор левой отметки означает меньшую нагрузку на сеть и большую на процессор, а правой отметки - большую нагрузку на сеть и меньшую на процессор.

Итак, задав имя сервера, порт, имя сессии вам необходимо задать параметры рабочего стола:

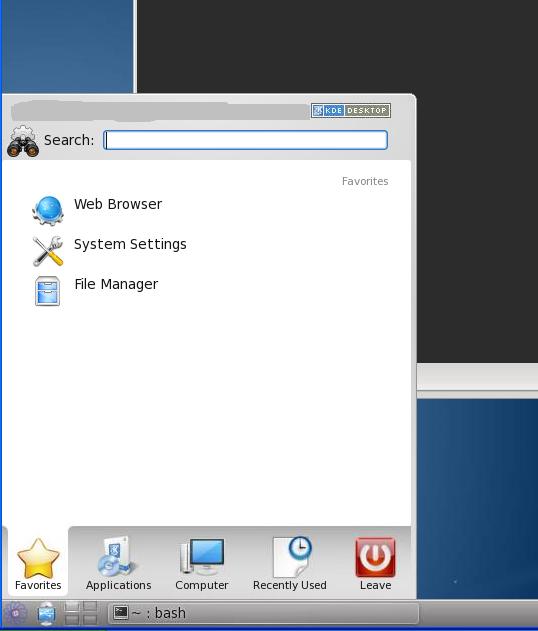

• Desktop - выбор параметров рабочего стола. В одном выпадающем списке выбирается ОС, запущенная на сервере, к которому планируется подключение. Во втором выпадающем списке выбирается графическая оболочка (Gnome, KDE, пр.), вход в которую будет осуществлен автоматически. Рекомендуем задавать KDE.

• Desktop - выбор параметров рабочего стола. В одном выпадающем списке выбирается ОС, запущенная на сервере, к которому планируется подключение. Во втором выпадающем списке выбирается графическая оболочка (Gnome, KDE, пр.), вход в которую будет осуществлен автоматически. Рекомендуем задавать KDE.

• Display - установка размеров экрана. Можно выбрать конкретные значения (например, "640х480" или "800х600" и т.д.), можно выбрать полноэкранный (Fullscreen) или пользовательский (Custom) размеры...

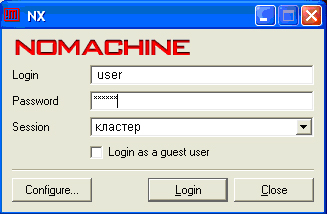

Следующее диалоговое окно будет завершающим настройку соединения. - В дальнейшем вызвав NX Client for Windows и задав сессию

вы можете увидеть примерно следующее:

Примечание:

Сессия считается завершенной только после выключения компьютера. Закрыв окно сессии, вы можете вернутся к истории ваших команд, если повторно закажите сессию.

Настройка русской клавиатуры в NX клиенте

Для настройки русской клавиатуры в NX клиенте используются стандартные механизмы Linux. В графической среде, установленной на кластере "Уран", настройка выполняется следующим образом:

Нажимаем на кнопку "Пуск" в левом нижнем углу Linux'овского рабочего стола.

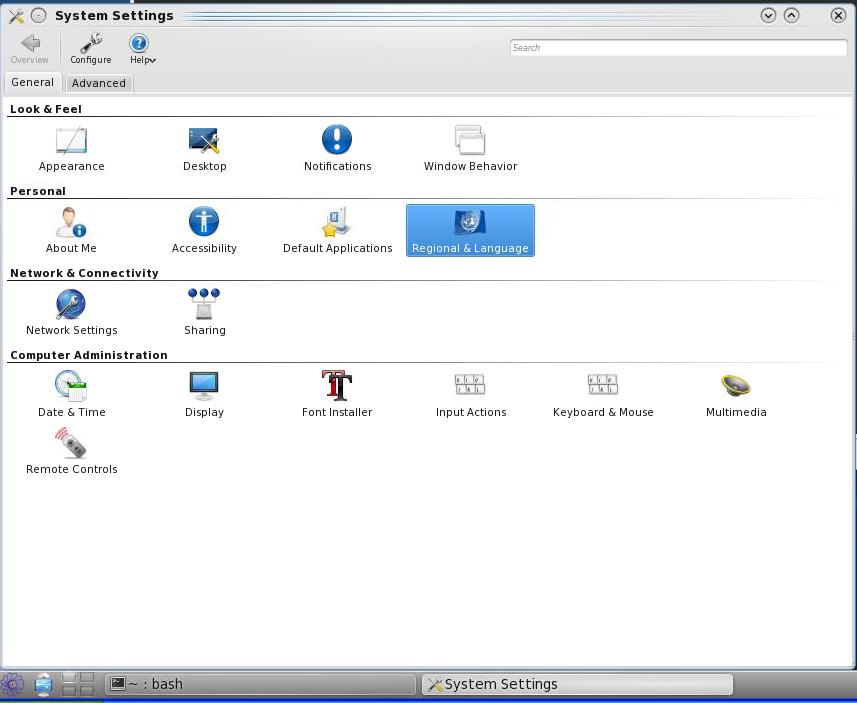

Выбираем меню "System settings"->"Regional & language"

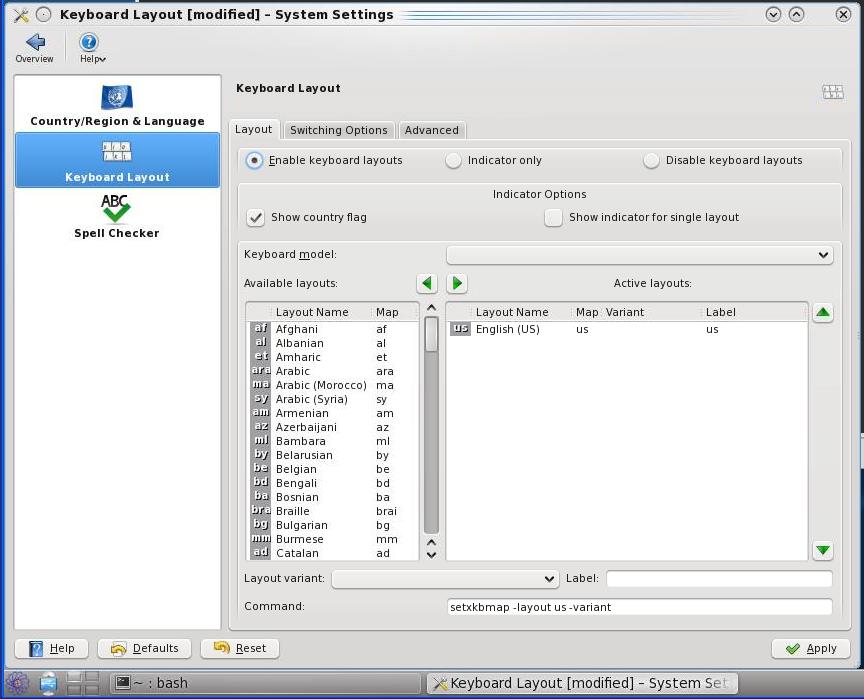

Выбираем подпункт "Keyboard layout" и на вкладке "Layouts" ставим галочку в "Enable keyboard layouts"

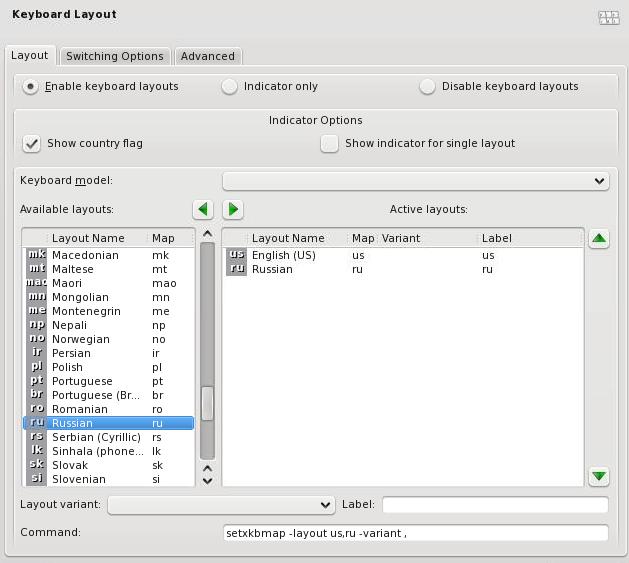

Добавляем русский язык в "Active layouts"

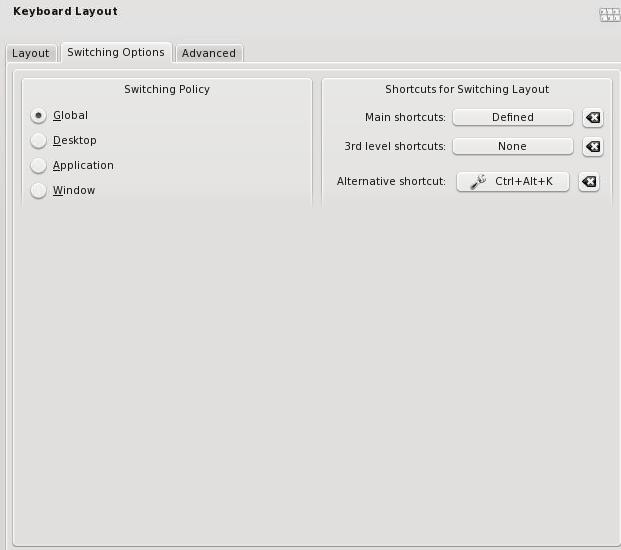

На вкладке "Switching options" и "Advanced" выбираем сочетание клавиш для переключения раскладок и объекты на которые распространяется действие переключения. На скриншотах переключение настроено по сочетанию клавиш "Alt+Пробел" одновременно для всех запущенных программ.

Запуск задач на кластере

ВНИМАНИЕ: c 16.03.2022 запуск задач должен осуществляться в подкаталогах ~/_scratch и ~/_scratch2. Запись данных в другие подкаталоги домашнего каталога на вычислительных узлах будет заблокирована.

Каталоги ~/_scratch и ~/_scratch2расположены в отдельных системах хранения: _scratch — на параллельной файловой системе Lustre, _scratch2 — на SSD-дисках. Эти файловые системы также могут быть видны под именами /misc/home1/uXXXX — _scratch и /misc/home6/uXXXX — _scratch2, где uXXXX — логин пользователя.

При запуске задачи пользователя на счет

- необходимо учитывать ограничения по ресурсам для пользователей;

- желательно использовать тот модуль установки переменных окружения, с которым программа была откомпилирована;

- пока задача не просчиталась, нельзя ее перекомпилировать, удалять исполняемый файл и менять входные данные.

Запуск программ осуществляется в системе SLURM. Основные команды SLURM приведены в инструкциях ниже. Полная информация выдаётся с помощью команды man.

В результате запуска задача помещается в очередь заданий и ей присваивается уникальный идентификатор (JOBID). Его можно узнать командами mqinfo, mps или squeue, sacct.

На основе команд SLURM (которые начинаются с буквы s) для удобства пользователей (в частности, обеспечения преемственности при переходе на SLURM) были реализованы упрощённые команды запуска MPI-, MATLAB-, ANSYS-программ и информационные команды (начинающиеся с буквы m).

Упрощённые команды

mqrun, замена mpirun, — запуск программы на кластере, аналог команды sbatch.

mqinfo — выдача информации об узлах и очереди заданий с помощью команд sinfo и squeue ( Пример выдачи sinfo из команд mqinfo и mps).mps или mqinfo -u $USER -l — выдача информации об узлах и задачах только самого пользователя.mqdel, mkill — отмена выполнения задачи (ожидающей старта или уже стартовавшей), действуют как команда scancel.

Команда mqrun (замена mpirun, аналог sbatch ) запускает в пакетном режиме успешно откомпилированную С- или Fortran-программу, например

mqrun -np 8 -maxtime 20 -stdin in.txt mytestгде для mytest затребовано формирование 8 процессов (опция -np или -n) с выделением каждому по умолчанию 1950 MB (т.е. --mem 1950) и установкой входного файла (-stdin) при ограничении времени счета 20-ю минутами (–maxtime или –t). Так как не указаны опции -stdout и -stderr, то стандартными выходными файлами будут автоматически созданные mytest.1/output, mytest.1/error.

В ответ в строке вида Submitted batch job 1475 выдаётся уникальный идентификатор (JOBID) задачи в очереди заданий, здесь 1475. Уникальный идентификатор используется в командах отмены выполнения задания, например

mqdel 1475 #или mkill 1475Внимание!

1. В каталогах вида имя_программы.номер номера возрастают, начиная с 1. Пользователь должен сам удалять ненужные каталоги.

2. Для выдачи опций mqrun следует набрать

mqrun -help3. При необходимости можно указать опции команды sbatch в качестве значения параметра --slurm-opts команды mqrun, например:

mqrun -n 6 -nh 2 --slurm-opts '--ntasks-per-node=3 --gres=gpu:3 -x tesla[49,52]' ./testКоманды запуска SLURM

Система SLURM позволяет с помощью команд sbatch и srun работать соответственно в пакетном и интерактивном режимах. Пакетный режим является основным в работе с кластером.

Команда sbatch для запуска программы в пакетном режиме имеет вид

sbatch [опции] --wrap="srun <имя программы> [параметры программы]"

или

sbatch [опции] <имя скрипта> [параметры скрипта]

Минимальный скрипт может выглядеть так

#!/bin/bash

srun myprogram param1 param2

Внимание!

Библиотека OpenMPI работает только с командой sbatch и при этом перед именем программы в опции --wrap или в скрипте вместо srun добавляется orterun:

sbatch [опции] --wrap="orterun <имя программы> [параметры программы]"

Команда srun для запуска интерактивной программы имеет вид

srun [опции] <имя программы> [параметры программы]

Опции

-n <число процессов>если число процессов (tasks) не задано, то по умолчанию n=1.-t <время>при отсутствии заказа времени для решения задачи выделяется по умолчанию 30 минут. Максимальное время для счета задачи:- 20 часов - в будние дни (с 9 часов понедельника до 16 часов пятницы);

- 85 часов - на выходные (с 16 часов пятницы до 9 часов понедельника плюс 20 часов), т.е. на 85 часов задача запустится, если она войдет в решение в 16 часов ближайшей пятницы, иначе будет ждать следующей; аналогично, на 84 часа есть шанс запустить до 17 часов пятницы и т.д. до 9 часов понедельника;

- 100 часов - если к выходным добавляются праздничные дни.

Время может быть задано в виде:

- минуты

- минуты:секунды

- часы:минуты:секунды

- дни-часы

- дни-часы:минуты

- дни-часы:минуты:секунды

-N <кол-во узлов>задает число узлов (nodes) для задачи, если пользователю это важно.Для увеличения оперативной памяти можно воспользоваться опциями:

--mem-per-cpu=<MB>задаёт минимальную память в расчёте на одно ядро в мегабайтах ; если не задано, то по умолчанию 1 ГБ;--mem=<MB>задаёт память на узле в мегабайтах.

Эти опции взаимно исключают друг друга.--gres=gpu:<тип GPU>:<кол-во GPU>задаёт запуск программы на узлах с GPU. Еслиgresне задан, то количество GPU=0, т.е. GPU при счете не используются. Если не указан тип GPU, то автоматически назначается младшая модель (m2090). Типы GPU в 2024 году m2090, k40m, v100, a100.-p <раздел>или--partition=<раздел>позволяет указать раздел (partition) кластера для запуска задачи.

Основные разделы: tesla, apollo, hiperf и debug. Эти разделы покрывают весь кластер и взаимно не пересекаются, т.е. содержат разные узлы (см. Кластер «Уран»). Раздел v100 в 2024 году состоит из одного узла tesla-a101. Список всех разделов выдается командойsinfo -s. Если раздел не задан пользователем явно, то по умолчанию будет выбран раздел apollo, но при отсутствии в нем нужного числа свободных процессоров будет задействован раздел tesla.

-p debugпозволяет запускать задачи в специально выделенном для отладки программ разделе debug с максимальным временем счета 30 минут. Например,srun -p debug mytest

Опции -w, -x, -С позволяют более гибко регулировать список узлов, допустимых для запуска задачи (см. man sbatch).

Например:

-w tesla[5-7,15]- выделить заданию ресурсы узлов tesla5, tesla6, tesla7, tesla15, а если на них не хватит, то и другие узлы;-x tesla22- не выделять заданию ресурсы узла tesla22;-С a2017- выделять задаче только те узлы, которые имеют ресурс с именем (Feature), указанным после-C. На кластере имеются ресурсы с именами: tesla, a2017, a2019 (поколения узлов); bigmem (узлы с большим объёмом ОЗУ), a100, v100 (модель GPU). Информацию о том, какие ресурсы есть на конкретном узле, можно получить командой видаscontrol show node tesla22.

Описание всех опций и примеры команд можно посмотреть в руководстве man с помощью команд:

man sbatch

man srun

По умолчанию стандартный вывод пакетной задачи и стандартный поток ошибок направляются в файл с именем slurm-%j.out, где %j заменяется уникальным идентификатором (номером) задачи. Перенаправление ввода-вывода можно выполнить, указав программе sbatch опции

--input=<filename pattern>--output=<filename pattern>--error=<filename pattern>

При задании имени файла (filename pattern) можно использовать символы замены, в частности, %j заменяется на JobID, %t - на номер процесса в рамках задания. Таким образом file_%j_%t.txt при каждом запуске задачи сгенерирует уникальные имена для каждого процесса.

Выдаваемые результаты конкретной команды srun можно поместить вместо стандартного в указанный файл, добавив после команды символ перенаправления вывода >.

srun mytest > out_mytest &

Можно (чаще, при интерактивном запуске) параллельно просматривать результаты и сохранять их в файле, например:

srun --mem 40000 mytest | tee out_mytest

Примеры запуска

В результате интерактивного запуска программы hostname выдаётся имя узла, на котором запущен соответствующий процесс, например:

u9999@umt:~$> srun hostname

apollo5

При запуске в пакетном режиме команда запуска программы задаётся либо в скрипте, либо через опцию --wrap, например,

sbatch -n 2 --wrap="srun hostname"

или

sbatch mybat

где скрипт mybat:

#!/bin/sh

#SBATCH -n 2

srun hostname &;

wait

Внимание!

- Команда

srunвнутри скрипта может запрашивать ресурсы только в тех пределах, которые установлены командойsbatch. - Скрипт запускается только на первом из выделенных узлов.

- Запуск нескольких процессов осуществляется командой

srun. При этом все опции, указанные в командной строке или самом скрипте в строках#SBATCH, приписываются к каждой командеsrunданного скрипта, если не переопределены в ней. Так, результирующий файл приведённого примера будет содержать 2 строки с именами узлов (возможно, одинаковых), на которых выполнятся 2 процесса задачи, сформированные командой srun. - Если команды srun запускаются в фоновом режиме (символ

&в конце строки), то они при наличии ресурсов могут выполняться одновременно.

Примеры постановки задач в очередь

u9999@umt:~$ sbatch -n 3 --wrap="srun mytest1 3 5.1"

Submitted batch job 776

сформирована пакетная задача с запуском 3-х процессов mytest1 c 2-мя параметрами. Задаче присвоен уникальный идентификатор 776.

u9999@umt:~$ srun -N 2 sleep 30 &

[1] 22313

сформирована интерактивная задача в фоновом режиме. [1] - номер фоновой задачи в текущем сеансе, 22313 - pid процесса srun на управляющей машине. Уникальный идентификатор можно узнать с помощью команд squeue, sacct.

Пример задачи, рестартующей после истечения заказанного времени

Все опции запуска описаны в batch-файле. За 60 секунд до окончания заказанного времени все процессы, запущенные через srun получат сигнал TERM и завершатся, после чего последняя команда в скрипте restart_sbatch снова поставит его в очередь. Перезапуск произойдёт и в том случае, когда программа, запущенная через srun завершится самостоятельно.

Опция --signal задаёт номер сигнала, который будет отправлен процессам (KILL) и время отправки сигнала (60 секунд до конца заказанного времени счёта).

Запуск

sbatch restart_sbatch

Содержимое restart_sbatch:

#!/bin/sh

#SBATCH -n 1 -t 180

#SBATCH --signal=KILL@60

srun myprog arg1 arg2

# здесь можно вставить анализ результатов,

# формирование новых параметров,

# проверку условий завершения

# и т.п.

sbatch ./restart_sbatch

Запуск массива задач

Массив задач, это средство быстрого формирования очень большого задач, без повышения нагрузки на очередь задач и планировщик.

При формировании массива указывается список индексов, либо стартовый индекс, максимальное значение индекса и его шаг. Запускаемая задача может проверить в переменных окружения параметры массива и назначенное текущему экземпляру значение индекса.

# Перебираем индексы от 0 до 31 включительно

$ sbatch --array=0-31 -N1 myjob

# Перебираем индексы 1, 3, 5, 7

$ sbatch --array=1,3,5,7 -N1 myjob

# Перебираем индексы от 0 до 7 включительно с шагом 2

$ sbatch --array=1-7:2 -N1 myjob

# Дополнительно после символа % можно указать максимальное количество экземпляров, считающихся одновременно

sbatch --array=0-31%5 -N1 myjob

Например, задача, запущенная командой sbatch --array=1-3 -N1 myjob, увидит следующий набор переменных окружения:

SLURM_ARRAY_TASK_ID=3

SLURM_ARRAY_TASK_COUNT=3

SLURM_ARRAY_TASK_MAX=3

SLURM_ARRAY_TASK_MIN=1

Далее можно сформировать параметры используя значения переменной SLURM_ARRAY_TASK_ID. Например, программа myjob может прочитать нужную строку из файла параметров и передать её дальше в качестве аргументов для вычислений:

#!/bin/bash

PARAMS=$(head -n $SLURM_ARRAY_TASK_ID params.txt | tail -n1)

./exefile $PARAMS

Запуск интерактивных задач

Иногда бывает необходимо запустить на кластере интерактивную программу или подключиться к уже запущенной программе в интерактивном режиме (например для запуска отладчика). Ниже рассмотрено несколько вариантов запуска интерактивных программ.

Запуск интерактивной программы

Для взаимодействия с пользователем через текстовый интерфейс программа обращается к специальному устройству — псевдотерминалу (pseudo teletype, PTY). Для создания такого устройства на узлах необходимо указать команде srun опцию --pty.

В примере ниже для задачи выделено два узла, но интерактивный интерпретатор командной строки запущен только на первом из них.

[host]$ srun -n 36 -t 40 --pty bash

[node19]$ echo $SLURM_NODELIST

node[19,23]

Если вы работаете в графической среде XWindow (клиенты X2Go, Mobaxterm и т.п.), то по такой же схеме можно запускать на узлах задачи с графическим интерфейсом. Единственное отличие — при запуске надо добавить опцию --x11. По умолчанию графический вывод возможен с любого из выделенных узлов.

[host]$ srun -n 8 -N 1 -t 40 --pty --x11 matlab

Подключение к запущенной задаче